Beobachtung und Vorhersage

Einleitung

Dieses Kapitel befasst sich mit Beobachtungsverfahren, Messsystemen, Klimamodellen zur Vorhersage sowie ENSO-Vorhersagen und deren Nutzen. Aktuelle Daten bzw. die externen Links zu ihrer Beschaffung finden Sie hingegen im Kapitel Aktueller Zustand des Pazifiks.

Wie schon im Überblickskapitel dargestellt, bezieht sich ENSO auf den Wechsel zwischen der El Niño-Phase im tropischen Pazifik und seiner gegenteiligen Phase, der La Niña sowie der Neutralphase. Der Southern Oscillation Index erfasst die Ost-West-Unterschiede des Luftdrucks in Bodennähe, welche diese Veränderungen begleiten. ENSO wird ferner begleitet durch Änderungen der Meerestemperaturen und von Verschiebungen der atmosphärischen Zirkulation, wobei einige Aspekte vorhersagbar erscheinen. Das bedeutet, dass man mit Hilfe von Beobachtungen des Klimas und der Meerestemperaturen, insbesondere im Bereich des tropischen Pazifiks, und von Modellen, die unser Verständnis von Klimavariabilität beschreiben, mit einer gewissen Kompetenz die ENSO-Bedingungen vorhersagen und Prognosen für Lufttemperaturen und Niederschläge in anderen Gebieten machen können.

Seit Wissenschaftler vor über 40 Jahren erkannt haben, dass ozeanische und atmosphärische Teile von ENSO eng miteinander verbunden sind, haben sie begonnen,die kombinierten Phänomene aus einer Vielzahl von Perspektiven aus zu betrachten und schufen so ein tieferes Verständnis für dieses komplexe und einflussreiche Naturphänomen.

Als 1982–83 ein starkes El Niño-Ereignis ohne Vorwarnung einsetzte, erkannten die Wissenschaftler es erst nachdem es sich entwickelt hatte. Dies lag an den beschränkten Beobachtungsmöglichkeiten, den noch primitiven Computermodellen, den gleichzeitig auftretenden Auswirkungen eines Ausbruchs des mexikanischen Vulkans El Chichón im Jahr 1982 und schließlich auch an der fehlenden Erkenntnis über die Entwicklungsvariabilität verschiedener El Niños. Erst der folgende Aufbau eines ENSO-Beobachtungssystems im tropischen Pazifik brachten wesentliche Erkenntnisse für die Frühwarnung.

Ständige Schwankungen in den 1960er und 1970er Jahren formten das frühe Verständnis von ENSO. Die 1980er und 1990er wurden von El Niño-Phasen dominiert, einschließlich der starken Ereignisse von 1982/83 und 1997/98. Auch das Ereignis von 2015/16 war von Eigenheiten im Vergleich zu anderen Starkereignissen geprägt.

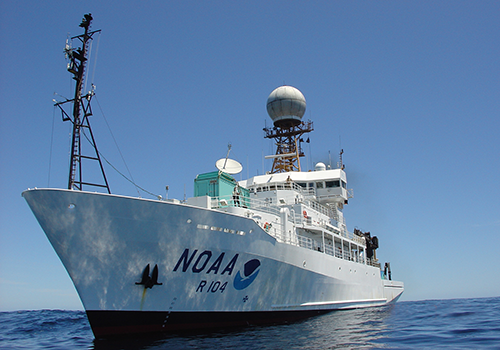

Wissenschaftler der NOAA und anderer Wetterbehörden sowie von wissenschaftlichen Instituten setzen heute eine Vielzahl von Instrumenten und Methoden ein zur Beobachtung und Vorhersage von Veränderungen im Pazifik und von deren Auswirkungen auf globale Wettermuster. Im tropischen Pazifik sind dies u.a. verschiedene Typen von Bojen, schiffgestützte Messungen und Satellitenbeobachtungen.

Aus historischer Perspektive ist anzumerken, dass moderne, auf ENSO bezogene Beobachtungsdaten teilweise bis in das späte 19. Jahrhundert zurückreichen. Da solide Beobachtungen im tropischen Pazifik in der frühen Beobachtungsperiode allerdings nur in spärlichem Umfang vorliegen, werden Datensätze üblicherweise aus den wenigen Beobachtungen, zusätzlich mit Modellen und mit statistischen Methoden erstellt.

Die Abbildung oben zeigt ENSO-Indizes von Beginn des 20. Jahrhunderts an: Die Anomalien der Meeresoberflächentemperaturen (SST) in der Niño 3-Region (150°W-90°W, 5°S-5°N) und der Niño 4-Region (160°E-150°W, 5°S-5°N), sowie die zonalen Windanomalien in der Niño 4-Region. Aus dieser Abbildung kann man mehrere Punkte ableiten:

- Die SST und die zonalen Windanomalien sind stark korreliert, was auf den Charakter von ENSO als gekoppeltes Ozean-Atmosphäre-Phänomen hinweist.

- Diese ENSO-Indizes zeigen ein oszillatorisches Verhalten mit einem bevorzugten Rhythmus von 3-5 Jahren, auch wenn die Oszillation eine beträchtliche Unregelmäßigkeit besitzt.

- ENSO-Ereignisse zeigen eine Asymmetrie zwischen den warmen El Niño- und den kalten La Niña-Ereignissen, wobei die Anomalien von El Niño stärker sind als jene von La Niña.

- Die Abb. (b) zeigt, dass die Warmereignisse im zentralen Pazifik (dargestellt im Niño 4-Index) in den letzten paar Dekaden häufiger aufgetreten sind.

Ein weiteres Merkmal, das allerdings nicht klar aus der oben stehenden Abbildung abgelesen werden kann, ist der phasenstarre Charakter von ENSO in Bezug auf das jahreszeitliche Auftreten. Gemeint ist, dass ENSO-Ereignisse dazu tendieren, ihre stärkste Ausprägung während des Nordwinters zu erreichen (z. B. Rasmusson und Carpenter 1982).

|

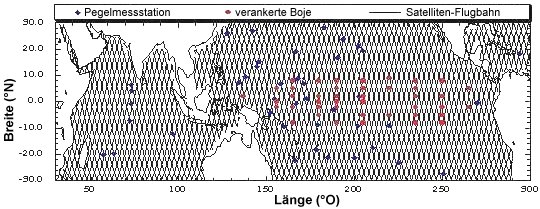

Global Tropical Moored Buoy Array Quelle: NOAA (dort auch aktuelle Version der Grafik) |

Das Global Tropical Moored Buoy Array Program ist ein multinationales Projekt zur Bereitstellung von Daten in Echtzeit für die Klimaforschung und -vorhersage.

|

Die Lage der Thermokline und ihre Änderungen sind während ENSO-Ereignissen sehr bedeutsam, aber Messungen der Meerestemperatur unterhalb der Oberfläche waren in der Vergangenheit nur sehr spärlich. Der Mangel an Daten und fehlende Kenntnisse über die Ozean-Atmosphäre-Interaktion führten in den 80er und 90er Jahren zu einem zehnjährigen, auf die Tropenmeere bezogenen Forschungsprogramm im Rahmen des World Climate Research Programmes: Das Tropical Ocean Global Atmosphere program (TOGA). Dem Programm lag das Bewusstsein zugrunde, dass sich die dynamische Anpassung des Ozeans in den Tropen rascher vollzieht als in den höheren Breiten. Beispielsweise können sich Störungen, die aus dem Westpazifik im Rahmen eines El Niño-Ereignisses heraus auftreten, innerhalb von Wochen quer über das Ozeanbecken ausbreiten, wohingegen sie in höheren Breiten Jahre für die gleiche Strecke benötigen würden.

Eine der Errungenschaften des TOGA-Programms (1985-1994) war der Aufbau eines ENSO-Beobachtungssystems im tropischen Pazifik. Das Rückgrat des operationell arbeitenden ENSO-Beobachtungssystems läuft heute unter der Bezeichnung TAO/TRITON Array und besitzt ca. 70 verankerte Bojen (Hayes et al. 1991; McPhaden 1995), die von den USA und von Japan eingerichtet und unterhalten werden.

Beobachtung des ENSO-Phänomens

Operationelle Datenerhebung

Generell werden heute Daten zur Beobachtung und Vorhersage von El Niño-/La Niña-Ereignissen geliefert von

- Pegelstationen auf Land

- Satelliten (Doppelrolle, einerseits Träger von Sensoren, andererseits Datenübermittler, z.B. von Bojen zu Forschungsstationen auf Land)

- fest verankerten Messbojen

- frei schwimmenden (driftenden) Messbojen

- Schiffen, auf jeweils freiwilliger Basis: das ozeanographische Programm Ship Of Opportunity Program (SOOP) oder das meteorologische Programm Volunteer Observing Ship (VOS)

- Wind-Profilern

Mit Hilfe dieser Daten versuchen die Klimaforscher, die Vorgänge im pazifischen Ozean und der darüberliegenden Atmosphäre mit Computermodellen auf Grossrechnern zu simulieren. Dies ist eine komplexe Aufgabe, weil es zum einen noch nicht seit langer Zeit solche Klimadaten über den Pazifik gibt und zum anderen, weil die Vorgänge in der Natur nicht linear sind, sondern auch schon kleine Veränderungen große Auswirkungen haben können. Ferner gibt es noch immer deutlich zu wenige Beobachtungspunkte, insbesondere was die Tiefen des Ozeans betrifft.

Moderne dynamische und statistische Vorhersagemodelle können die Wahrscheinlichkeit eines El Niño- oder La Niña-Ereignisses heute mit erstaunlicher Güte bis zu einem halben Jahr im Voraus vorhersagen, allerdings wird die maximale Intensität noch nicht sehr gut getroffen. Jedoch sind die Fernwirkungen auf andere Regionen nur ungenau vorhersagbar, da dabei auch andere Faktoren ins Spiel kommen. Viele Aspekte der Frage, wie ein El-Niño-Ereignis im einzelnen ausgelöst wird, sind noch Gegenstand der Forschung.

Jedes Forschungszentrum stützt sich bei seinen ENSO-Updates auf eine Reihe von Kerndatensätzen, so dass die genauen Werte für eine bestimmte Größe (z.B. Niño-3.4 SST) variieren, je nachdem, welcher Datensatz untersucht wird. Diese Unterschiede zwischen den Datensätzen ergeben sich in erster Linie aus strukturellen Gründen, wie z. B. der Wahl des dynamischen Modells oder der statistischen Methode, mit der die verfügbaren Beobachtungen ergänzt werden. Besonders deutlich sind die Unterschiede im tropischen Pazifik, der große Regionen umfasst, die nicht durch Punktmessungen abgedeckt sind (z. B. Bojen, Schiffe). Viele Zentren verlassen sich zudem auf Datensätze, die nicht nur Bojen- oder Schiffsdaten, sondern auch Satelliteninformationen aufnehmen. Die moderne Satellitenaufzeichnung begann jedoch erst Ende der 1970er Jahre, was die Verwendung dieser Datensätze für historische Auswertungen, die weiter zurückreichen, verhindert. Darüber hinaus haben Satellitenschätzungen Verzerrungen (aufgrund von Problemen wie unterschiedlichen äquatorialen Überflugzeiten), die durch in situ Oberflächenbeobachtungen korrigiert werden müssen, und diese Korrekturen können im Laufe von Zeit und Raum variieren, wenn neue Satelliten aufgenommen werden. Einige Datensätze wie der NOAA Extended Reconstructed SST (ERSST) verzichten auf Satelliteninformationen, um die Konsistenz oder Homogenität des Datensatzes zu erhalten. Für Zwecke außerhalb historischer Vergleiche und zur Bereitstellung von ENSO-Updates in Echtzeit werden diese satellitengestützten Datensätze jedoch stark in Anspruch genommen, sowohl um ein Gesamtbild der ENSO-Entwicklung zu erhalten, wie auch um Ausgangsbedingungen für viele Vorhersagemodelle bereitzustellen. (L'Heureux et al. 2017)

"Except for the regular progression of the seasons, ENSO is the most predictable climate fluctuation on the planet. Its predictability is based on wind-driven seasonal variations in the amount of heat stored in the upper few hundred meters of the tropical Pacific Ocean. These variations affect sea surface temperatures, which in turn influence the global atmospheric circulation."

McPhaden, M. J., Zebiak, S. E., Glantz, M. H. (2006): ENSO as an Integrating Concept in Earth Science

Die Notwendigkeit, mit verschiedenen, möglichst Realzeit-Daten liefernden Systemen die Beobachtung zu betreiben, zeigte sich spätestens beim großen El Niño von 1982, der bereits in vollem Gange war, als die Wissenschaftler ihn bemerkten. Diese hatten vereinzelte Hinweise über deutliche Änderungen der Ozeantemperatur von entfernten Inseln im Pazifik ignoriert und vielmehr ihren Wettersatelliten vertraut, die nichts Ungewöhnliches aufzeichneten. Dies lag daran, dass die Temperaturmessungen durch die Stäube eines Vulkanausbruchs Mexiko (El Chichon) überlagert waren. Zwar waren schon Messbojen in Äquatornähe installiert, ihre Daten waren jedoch erst Monate später verfügbar, nachdem die Instrumente geborgen waren.

Die Aussagekraft der verschiedenen Systeme ist äußerst unterschiedlich, was an den folgenden Beispielen deutlich wird:

Pegelmessungen liefern zwar regelmäßig Daten, haben aber den Nachteil, dass sie an die zufällige Verteilung von Inseln und Küsten gebunden sind, was erhebliche Beobachtungslücken zur Folge hat. Gleiches gilt für Handelsschiffe, die im Auftrag der Forschung Messsonden auf ihren routengebundenen Fahrten aussetzen. Räumlich und zeitlich systematischer werden Daten hingegen von einem Netz fest verankerter Bojen geliefert.

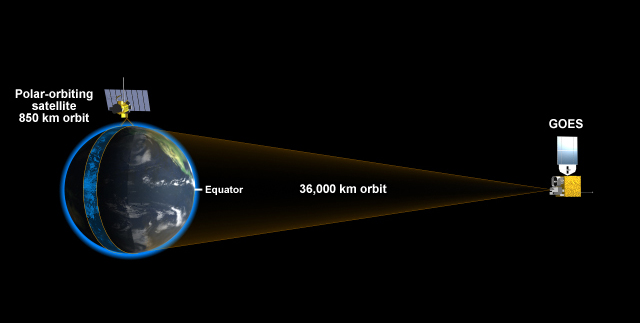

Satelliten auf einer Umlaufbahn vermögen zwar kontinuierlich Daten zu liefern. Es können bei jedem Überflug aber nur Daten aus Streifen von einigen 100 km Breite erfasst werden. Ein vollständiges Bild des tropisch-pazifischen Raumes entsteht folglich erst im Abstand einiger Tage.

Kontinuierliche Daten können demgegenüber von geostationären Satelliten geliefert werden, die jedoch jeweils nur den von ihnen aus sichtbaren Teil der Erdoberfläche darstellen können (z.B. die NOAA-Satelliten der Serie GOES: Geostationary Operational Environmental Satellite).

Der ENSO-Mechanismus beinhaltet zwar eine enge Verzahnung von ozeanischen und atmosphärischen Komponenten, die beiden Bereiche reagieren jedoch aufeinander in sehr unterschiedlichen Zeitskalen. Die Atmosphäre ist weniger dicht als der Ozean und reagiert deshalb fast sofort auf einen Impuls von der Ozeanoberfläche. Der Ozean ist vergleichsweise massiv und verhält sich folglich gegenüber einem atmosphärischen Forcing träge. Beispielsweise kann es sein, dass die Tiefe der Thermokline Monate benötigt, um sich veränderten Winden in den Tropen anzupassen, wohingegen sich atmosphärische Konvektion über warmem Wasser innerhalb von Stunden einstellen kann. Diese langsame Entwicklung des Temperaturfeldes im oberen Ozean liefert das "Gedächtnis" für das Klimasystem im tropischen Pazifik. Und es ist genau diese thermische Trägheit, die die Grundlage für die Vorhersagbarkeit für Veränderungen der ENSO-Zeitskala darstellt.

Vgl. die CLIVAR-Poster

El Niño Rapid Response Field Campaign (2016)

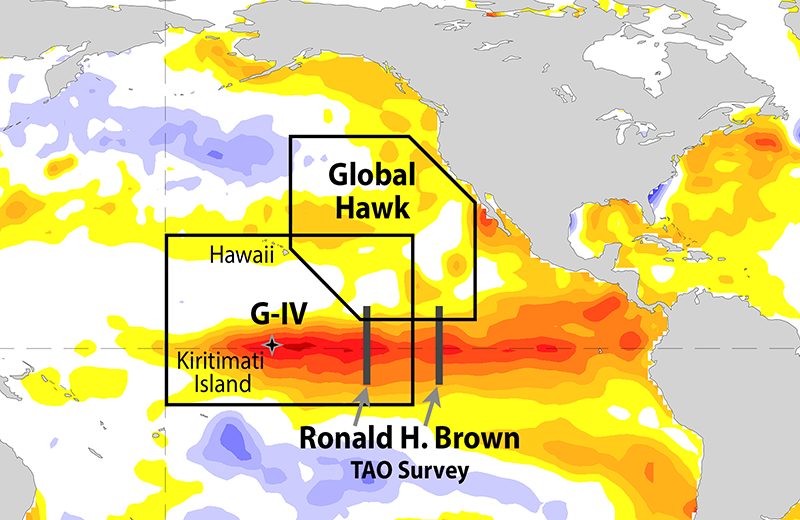

Während des El Nino 2015/16 haben Wissenschaftler der NOAA und von Partnerorganisationen im tropischen Pazifik zu Land, auf dem Meer und in der Luft eine Kampagne zur Untersuchung des Naturphänomens gestartet. Die dabei gewonnenen Daten sollen auch helfen, die Wettervorhersagen in weit entfernten Gebieten zu verbessern, insbesondere durch die Optimierung von Vorhersagemodellen. Gleichfalls dienen sie den jahresübergreifenden ENSO-Vorhersagen, sowie der höheren Genauigkeit von Modellen zur Langzeitvorhersage von Effekten des Klimawandels.

Die als El Niño Rapid Response Field Campaign bezeichnete Kampagne wird das NOAA-Forschungsflugzeug Gulfstream IV sowie das NOAA-Schiff Ronald H. Brown einsetzen, die NASA stellt ihre unbemannte Drohne Global Hawk zur Verfügung, die mit speziellen Sensoren ausgerüstet ist. Dazu kommen Forscher, die u.a. auf Kiritimati (vorm. Weihnachtsinsel) ca. 1340 Meilen südlich von Honolulu stationiert sind. Vom Boden aus lässt man Wetterballone aufsteigen, beobachtet die Atmosphäre mit Radaranlagen, und von Flugzeugen aus werden Instrumente abgeworfen, die zur Erdoberfläche schweben und dabei Wetterparameter messen.

|

Karte mit dem Einsatzgebiet der El Niño Rapid Response Field Campaign

Quelle: NOAA ESRL

|

Die Forschung im Kerngebiet dieses sehr starken El Niño wird den Meteorologen dabei helfen, das erste Glied in der Kette zu verstehen, die unter anderem Extremniederschläge an der US-amerikanischen Westküste verursacht.

Während der zwei vorangegangenen Extrem-El Niños wurde Kalifornien von intensiven Regenfällen durchnässt, was zu Überschwemmungen, Hangrutschungen und anderen Sachschäden führten. Kalifornien ist für die Forscher ein hochinteressantes Untersuchungsgebiet, insbesondere als der Staat seit langem versucht mit einer historischen Dürre fertig zu werden.

Derartige Untersuchungen während eines starken El Niño waren bislang noch nicht durchgeführt worden. Die Kampagne musste innerhalb relativ kurzer Zeit konzipiert werden, um die Chance zur Beobachtung des ablaufenden El Niño zu nutzen.

|

NOAA G-IV Aircraft Das NOAA-Flugzeug G-IV wird von Honolulu, Hawaii, aus fliegen und eine Reihe von meteorologischen Sensoren mit sich führen und während geschätzter 20 Forschungsflüge von Mitte Januar bis Anfang März 2016 Dropsonden einsetzen. Quelle: NOAA ESRL |

|

NASA Global Hawk Unmanned Aircraft Das Projekt Sensing Hazards with Operational Unmanned Technology (SHOUT) unter der Leitung des NOAA Unmanned Aircraft System (UAS)-Programms wird das NASA Global Hawk UAS mit einer Reihe von meteorologischen Sensoren und an Fallschirmen abgeworfenen Wetterinstrumenten während vier Forschungsflügen im Februar im östlichen Pazifik, nahe der US-Westküste, einsetzen. Das Flugzeug ist im NASA Armstrong Flight Research Center auf der Edwards Air Force Base stationiert. |

|

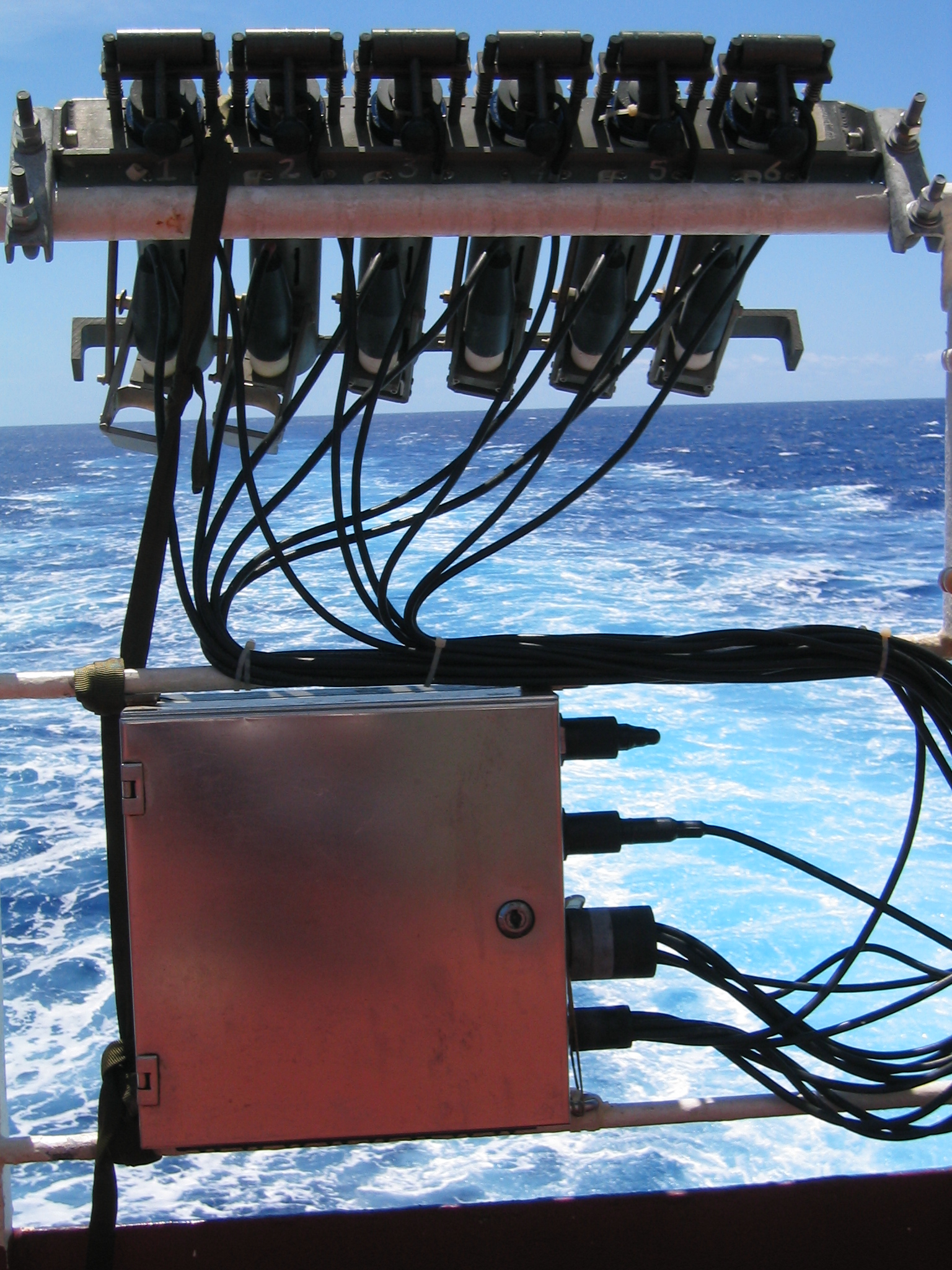

NOAA Research Ship Ronald H. Brown Das NOAA-Forschungsschiff Ronald H. Brown wird auf der Vermessungsfahrt Tropical Atmosphere Ocean (TAO) vom 16. Februar bis 18. März 2016 (Honolulu bis San Diego) bis zu 8-mal täglich Radiosonden (Wetterballons) starten. |

|

Scanning X-Band Radar Ein scannendes X-Band-Radar wurde vorübergehend in der südlichen Bucht von San Francisco installiert, um Abdeckungslücken im bestehenden Radarsystem zu schließen und genauere Niederschlagsschätzungen für die Region zu liefern, um mögliche Starkniederschläge und damit verbundene negative Auswirkungen von El Niño-Unwettern besser bewältigen zu können. |

|

Kiritimati Island Beobachtungen Auf Kiritimati (Christmas) Island, etwa 1.340 Meilen südlich von Honolulu, wird ein Sondierungssystem mit Radiosonden eingerichtet, das von Ende Januar bis März 2016 kontinuierlich zweimal täglich vertikale Sondierungen vornimmt. Das Bild wurde von der Internationalen Raumstation aus aufgenommen. |

Weitere Informationen:

- NOAA El Niño Rapid Response Field Campaign (NOAA ESRL 2016)

- The El Niño Rapid Response Campaign: Monitoring the 2015-2016 El Niño from the land, sea, and air (NOAA, ENSO Blog; März 2016)

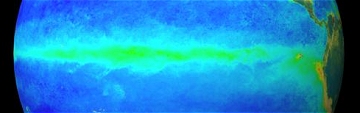

Das TAO/TRITON-Messnetz

Das Pacific Marine Environmental Laboratory (PMEL) der NOAA unterhält das weltgrößte System von im Ozean stationierten Wetterstationen, nämlich einen 8.000 Meilen langen Gürtel von ca. 70 instrumentenbestückten Bojen. Diese sind entlang des Äquators von Neu-Guinea bis Panama angeordnet, d.h. von ca. 8°N bis 8°S und von 137°O bis 95°W. Die gesammelten in situ-Informationen werden über das satellitengestützte Argos-System an das Institut übermittelt. Ursprünglich nur als Tropical Atmosphere-Ocean Array (TAO-Messnetz) bezeichnet, wurde es im Januar 2000 zu TAO/TRITON-Messnetz umbenannt, um der japanischen Beteiligung (JAMSTEC) mit ihren TRITON-Verankerungen Rechnung zu tragen.

|

Service an einer Boje des TAO-Messnetzes

Quelle: NOAA - Pacific Marine Environmental Laboratory

Link: The TAO Story - Developing an El Nino |

Dieses TAO-Messnetz ("Tropical Atmosphere-Ocean Array") misst ozeanographische und oberflächennahe meteorologische Variablen, die für das Erkennen, das Verstehen und die Vorhersage von saisonalen bis mehrjährigen Klimaschwankungen, die in den Tropen ihren Ausgang nehmen, von Bedeutung sind. Besonderes Augenmerk gilt ENSO-Ereignissen.

Per Satellitenübermittlung liefern die Bojen Klimaforschern und Wetterämtern rund um die Welt Echtzeit-Daten aus dem tropischen Pazifik. Das TAO-Messnetz wurde im Rahmen des 1994 abgeschlossenen internationalen TOGA-Programmes ("Tropical Ocean Global Atmosphere") eingerichtet. Die Notwendigkeit für die Etablierung eines solchen Ozean-Beobachtungssystems wurde in der Planungsphase für TOGA überdeutlich durch das Auftreten des extremen El Niño von 1982/83, der weder vorhergesagt, noch bis kurz vor seinem Höhepunkt als solcher erkannt wurde. Es fehlten Echtzeit-Daten.

|

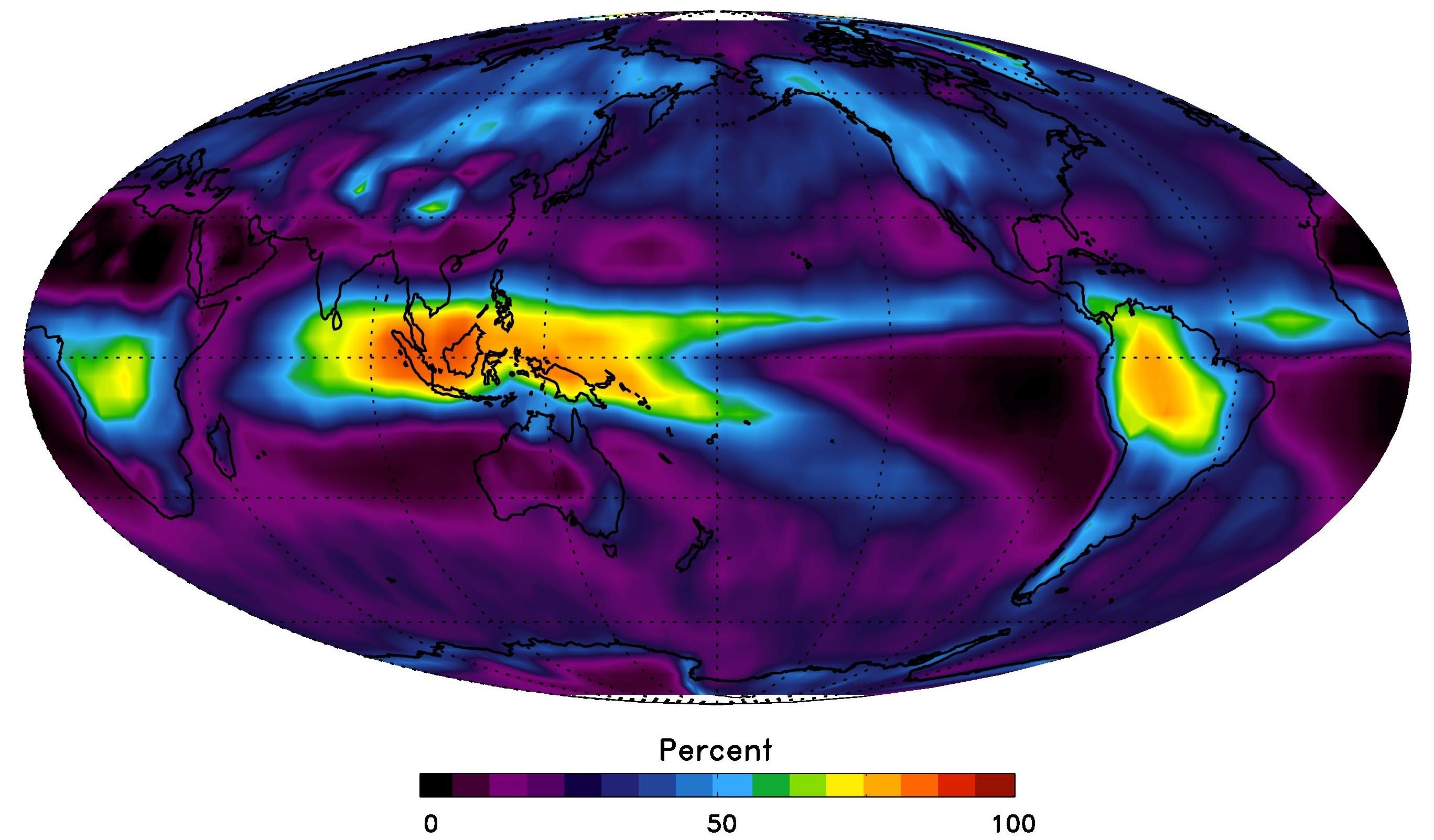

Bereich und Dichte von Temperaturmessungen der Meeresoberfläche Standorte von Messungen der Meeresoberflächentemperatur aus dem International Comprehensive Ocean Atmosphere Data Set (ICOADS) für 20-Jahres-Perioden, beginnend mit der Periode 1860-1879 und endend mit 1980-1999. Die Farben repräsentieren den Prozentsatz der Monate mit mindestens einer Messung der Meeresoberflächentemperatur in jedem 2 Grad mal 2 Grad Rasterfeld. Je dunkler die Farbe, desto höher ist der Prozentsatz der Monate in jeder 20-Jahres-Periode, die eine Beobachtung aufweisen. NOAA Climate.gov Bild mit Daten von ICOADS. Während es in den frühen 1980er Jahren einige Ozeanbeobachtungen von Schiffen, Bojen und Satelliten gab, existierte nichts mit den Fähigkeiten des TAO, bis... nun, TAO. Dies beinhaltet die Fähigkeit von TAO, nicht nur die Oberfläche, sondern auch den Untergrund im äquatorialen Pazifik zu messen. Der Untergrund kann der Ort sein, an dem sich die ganze "Action" in einem sich entwickelnden El Niño und La Niña abspielt, denn dort befinden sich die ozeanischen Kelvin-Wellen. Zu größerer Darstellung auf Grafik klicken (Web)

Quelle: NOAA - Climate.gov |

Schlüssel zur erfolgreichen Einrichtung von TAO war die Entwicklung von preisgünstigen ATLAS-Bojen ("Autonomous Temperature Line Acquisition System"), die wesentliche, für die Erforschung von ENSO wichtige Daten sammeln und übermitteln.

Jede Boje misst die Parameter Lufttemperatur, relative Luftfeuchte, wasseroberflächennahe Winde, Meeresoberflächentemperatur und Temperaturen des Wasserkörpers bis zu einer Tiefe von 500 Metern.

Zur Messung der Wasserströmung sind exakt entlang des Äquators (147°O, 165°O, 170°W, 140°W, 110°W) unter der Meeresoberfläche festverankerte Sensoren platziert. Es handelt sich um Acoustic Doppler Current Profiler (ADCP). Mit diesen Subsurface Current Meter Moorings werden auch die Parameter Druck und Temperatur gemessen. Alle Daten sind allerdings erst nach der Bergung der Messgeräte verfügbar.

In benachbarten ATLAS-Systemen werden in den oberen 300 m des Wasserkörpers an 4-5 Tiefenstufen ebenfalls die Strömungsverhältnisse gemessen. Diese Systeme liegen bei 165°O, 140°W und 110°W. Eine Echtzeit-Datenübertragung wird entwickelt.

Weitere Informationen über Temperatur und Salzgehalt aus der Tiefe liefern "Einweg"-Bathythermographen (XBT). Diese Geräte werden von Handelsschiffen ausgesetzt und übermitteln ihre Daten beim Absinken.

|

Aufbau der Bojen am Beispiel einer

Quelle:

|

Sämtliche Daten des TAO-Messnetzes werden mit Hilfe von NOAA-Satelliten zum Pacific Marine Environmental Laboratory (PMEL) der NOAA weitergeleitet, wo sie aufbereitet und der internationalen Wissenschaft verfügbar gemacht werden. Das Messnetz wird im westlichen Pazifik auch in Kooperation mit Japan, Korea, Frankreich und Taiwan unterhalten.

Im westlichen Pazifik (W von 156°O) werden seit 1998 18 PMEL-Bojen durch leistungsfähigere TRITON-Bojen (Triangle Trans-Ocean Buoy Network) des Japan Marine Science and Technology Center (JAMSTEC) ersetzt. Hierbei erfolgt eine enge messtechnische Abstimmung zwischen PMEL und JAMSTEC, um vergleichbare Daten zu erhalten. Beide Datenserien werden in einen gemeinsamen Datenpool eingespeist und sind frei verfügbar.

|

Karte der verankerten Bojen im TAO/Triton Messnetz |

Wasserstandsmessungen erfolgen zwar an Küsten von Kontinenten und Inseln, sowie durch Schiffe. Allerdings reicht das nicht aus, da beträchtliche Gebiete dadurch nicht abgedeckt werden. Messungen durch Handelsschiffe können nur in unregelmäßigen Abständen stattfinden, was die Verarbeitung der Daten verkompliziert. Deshalb stellt das TAO/TRITON-Messnetz eine wichtige Ergänzung dar (s. Karte unten).

|

Karte der Pegelmessstationen zusammen mit den verankerten Bojen und der

|

An einigen der TAO-Bojen wurden 1996 vom Monterey Bay Aquarium Research Institute biologische und chemische Sensoren angebracht. Sie messen die CO2-Konzentration und die biologische Produktivität in diesen Gebieten. Daten über die biologische Aktivität des Meeres liefert auch der Meeresbeobachtungssatellit der NASA SeaWiFS (Sea-viewing Wide Field-of-View Sensor).

Das internationale CLIVAR-Projekt (Climate Variability and Predictability) ist der Nachfolger zu TOGA und wird die bestehenden Systeme zur Beobachtung von Atmosphäre und Ozean übernehmen und erweitern. Dazu wird auch ein dem TAO-System vergleichbares Messnetz entlang des äquatorialen Atlantik eingerichtet. Gleiches ist auch für den äquatorialen Indischen Ozean vorgesehen.

Detaillierte Informationen zum TAO-Projekt finden sich auf der Website von PMEL.

Im Kapitel 'Aktueller Zustand des Pazifiks' befinden sich Links zu Webseiten, auf denen man aktuelle Messwerte dieser Bojen findet.

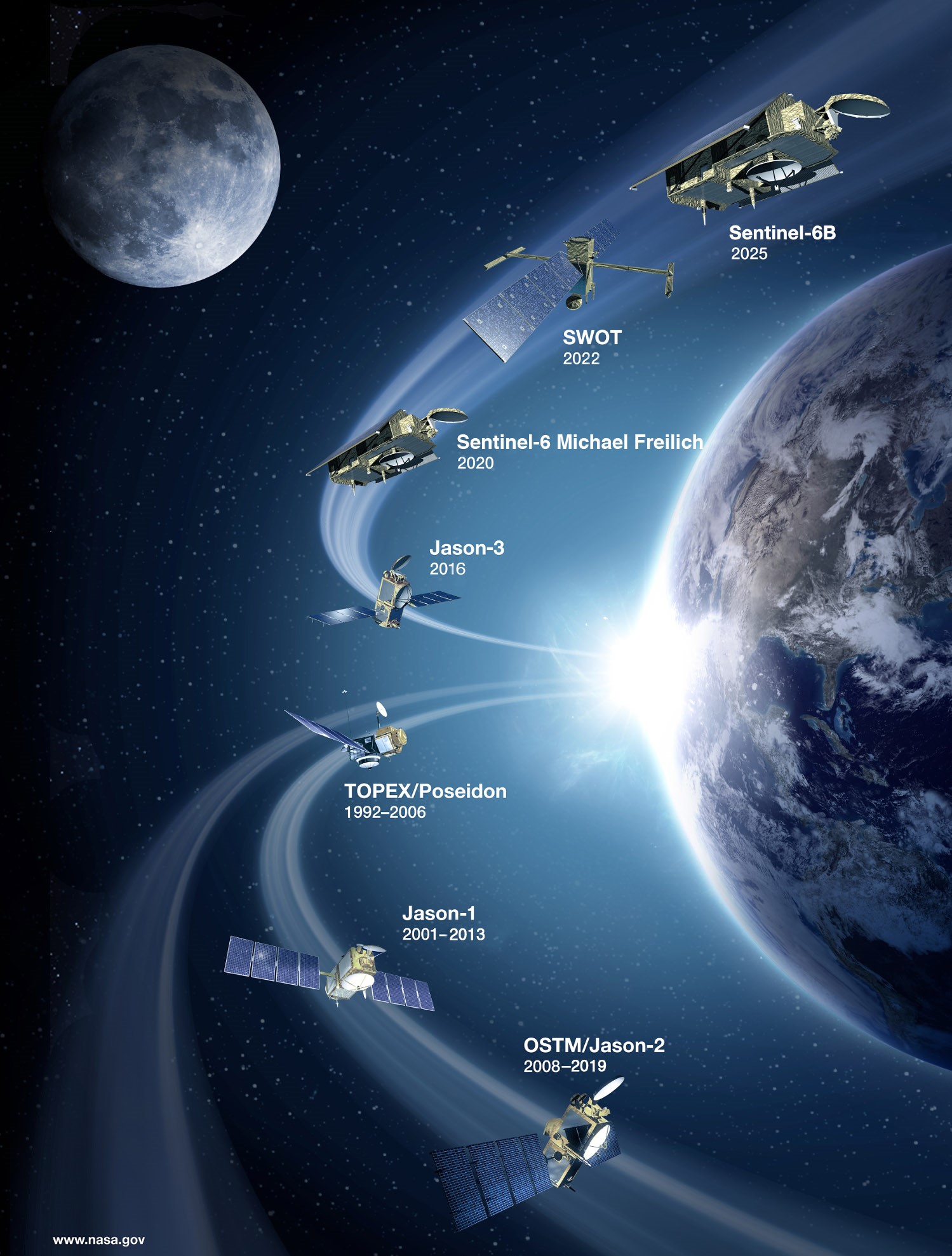

Höhenmessung (Altimetrie) mit Hilfe des Satelliten TOPEX/POSEIDON und Nachfolgemissionen

Genaue Daten über Änderungen der Meeresspiegelhöhe liefern den Wissenschaftlern, die sich mit der gekoppelten Modellierung des Ozean-Atmosphäre-Systems befassen, wichtige Informationen zur Abschätzung von Änderungen im Wärmehaushalt der oberen Wasserschichten. Diese wiederum sind für die Vorhersage von El Niño- bzw. La Niña-Ereignissen von wesentlicher Bedeutung.

Grundlage für präzise Altimetermessungen ist die genaue Kenntnis des Geoids als Ausdruck des irdischen Schwerefeldes. Diesbezüglich hochgenaue Informationen liefern seit wenigen Jahren die CHAMP- und GRACE-Missionen.

TOPEX/POSEIDON

Altimeter-Daten lieferte von 1992 bis 2006 vor allem der Satellit TOPEX/POSEIDON, ein Gemeinschaftsprodukt der amerikanischen Raumfahrtbehörde NASA und der französischen Weltraumbehörde CNES (Centre National d’Etudes Spatiales). Der Zweck des Satelliten war es, eine genaue Bestimmung der Höhe des Meeresspiegels relativ zum Erdmittelpunkt durchzuführen. Die ist von Ort zu Ort unterschiedlich.

Der mit einer Ariane 42P in seine Umlaufbahn gebrachte Satellit überflog die Erde in 1.336 km Höhe auf einer zu den Längengraden geneigten Bahn. Nach knapp zehn Tagen hatte er die Erde einmal vollständig umkreist und begann mit einem neuen Umlaufzyklus.

TOPEX/POSEIDON setzte Radar-Altimetrie ein, bei der Mikrowellen zur Wasseroberfläche gesandt und von dort reflektiert werden. Aus der Zeitspanne vom Senden eines Funkimpulses bis zu dessen Rückkehr nach Spiegelung an der Meeresoberfläche kann in Verbindung mit den genauen Lagedaten des Satelliten und anderen Bezugsgrößen die Meereshöhe bestimmt werden. Insbesondere benötigt man für die Satellitendaten die Informationen von Pegelstationen an Küsten und auf Inseln zur Kalibrierung.

Die Genauigkeit der Meeresspiegelmessungen liegen bei 1 bis 2 cm. Dabei werden Signale, die sich nur auf Gezeitenströme, Windschub und Atmosphärendruck beziehen, herausgerechnet. Die Datenauswertung erfolgt durch 38 Arbeitsgruppen in verschiedenen Ländern.

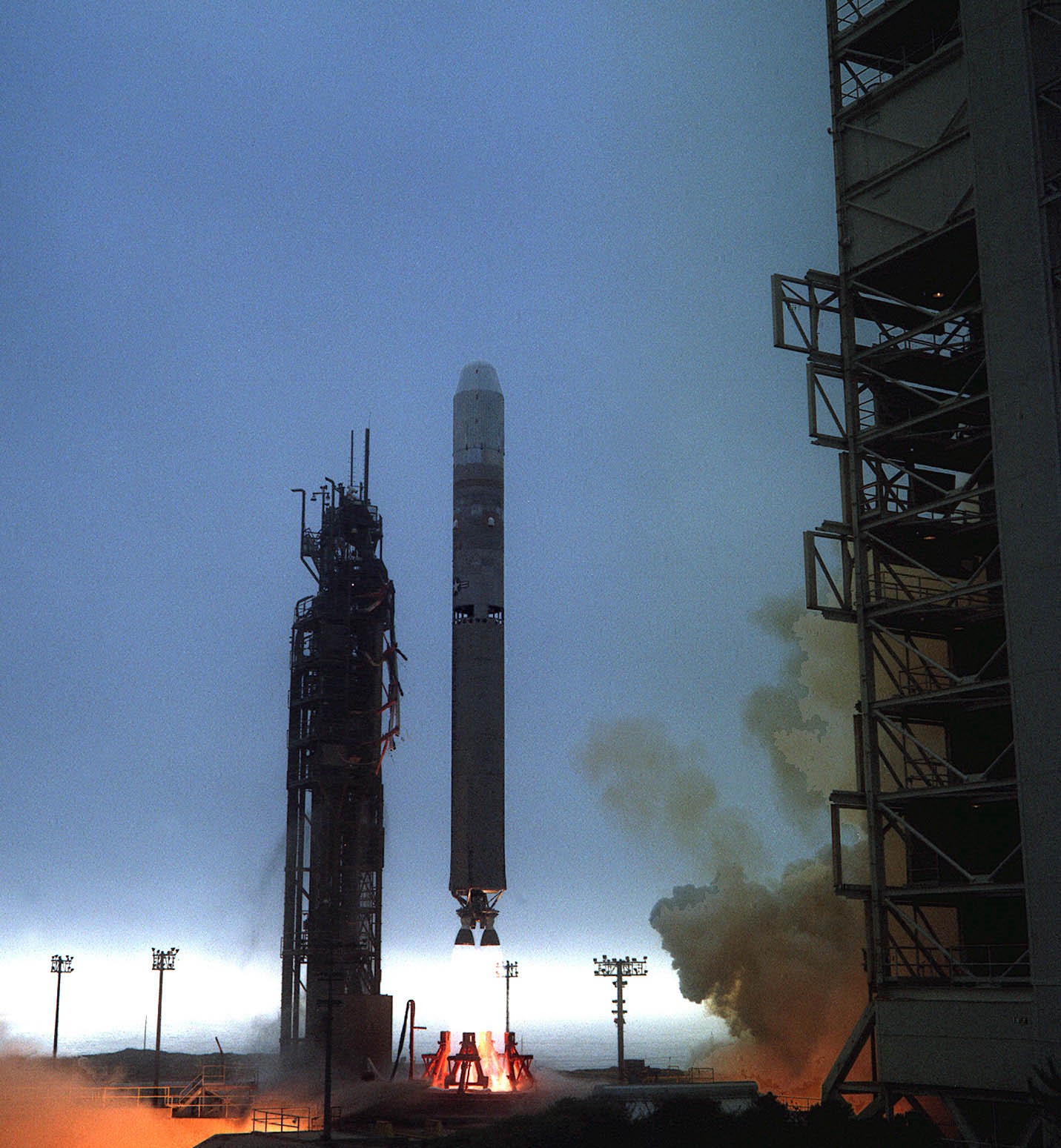

Das Programm TOPEX/POSEIDON war ursprünglich nur auf drei bis fünf Jahre anberaumt. Der 2001 gestartete Satellit JASON-1 sollte es ablösen. Während der zeitlichen Überlappung ihrer Aktivität wurden aber beide Satelliten in einer Tandemmission parallel genutzt. Jason-2, auch OSTM (Ocean Surface Topography Mission) genannt, folgte am 20. Juni 2008. Er wurde von Vandenberg aus auf eine 1340 km hohe zirkulare Kreisbahn mit 66° Bahnneigung gebracht. Der Satellit ist mit dem Zwei-Frequenz-Altimeter „Poseidon 3“ zur Bestimmung der Höhe von Meereswellen ausgerüstet.

Die TOPEX/Poseidon-Daten haben die Erforschung des globalen Ozeans revolutioniert. Zum ersten Mal wurden der jahreszeitliche Zyklus und andere zeitliche Variabilitäten des Ozeans global mit hoher Genauigkeit bestimmt, was grundlegend wichtige Informationen für das Testen von Ozeanzirkulationsmodellen lieferte. Wichtige Beobachtungen wurden mit TOPEX/Poseidon-Daten gemacht zu folgenden Themen

- Ozeanische Zirkulation einschließlich Details zur Bewegung von Rossby- und Kelvin-Wellen

- Ozeanische und küstennahe Gezeiten

- El Niño, La Niña und die Pacific Decadal Oscillation

- El Niño-ähnliche Zirkulation im Atlantik

- Ozeanische Jahreszeiten im Mittelmeer

- Topographie des Meeresbodens aus Oberflächendaten zur Optimierung des Geoidmodells

Jason-1

Jason-1 führte die wichtigen ozeanographischen Daten-Zeitreihen von TOPEX/Poseidon fort; dazu trug er aktualisierte Versionen der gleichen Instrumente. Er flog 5 Jahre lang im Tandem mit TOPEX/Poseidon. (Siehe die Flash-Animation der Tandem-Mission für weitere Details).

Das neu gestartete Radarinstrument der NASA zur Beobachtung des Ozeans, SeaWinds, hat die Wut des Taifuns Olga eingefangen, der letzte Woche im Chinesischen Meer an Intensität zunahm, hohe Windgeschwindigkeiten von mehr als 50 Knoten (57 Meilen pro Stunde) aufwies und sintflutartige Regenfälle über Südkorea, Nordkorea und andere Küstengemeinden in Südasien brachte.

OSTM/Jason-2

Die Ocean Surface Topography Mission auf dem Jason-2-Satelliten ist ein Nachfolgeprojekt von Jason-1. Sie bringt ozeanographische Studien der Meeresoberflächenhöhe in einen operationellen Modus für die weitere Forschung zur Klimavorhersage sowie für wissenschaftliche und industrielle Anwendungen.

Jason-3

Jason-3 wurde im Januar 2016 mit einer Falcon 9-Trägerrakete von der Vandenberg Air Force Base gestartet. Es ist die vierte Mission einer amerikanisch-europäischen Reihe von Satellitenmissionen zur Messung der Höhe der Meeresoberfläche. Die Mission verlängert die 1992 mit der TOPEX/Poseidon-Satellitenmission begonnene Zeitreihe zur Messung der Topografie der Ozeanoberfläche (die Hügel und Täler der Meeresoberfläche). Diese Messungen liefern den Wissenschaftlern wichtige Informationen über die Zirkulationsmuster im Ozean und über globale und regionale Veränderungen des Meeresspiegels sowie über die Auswirkungen einer Erwärmung des Klimas.

GRACE und GRACE-FO

Das Gravity Recovery and Climate Experiment (GRACE) flog zwei identische Raumsonden im Abstand von etwa 220 Kilometern auf einer polaren Umlaufbahn in 500 Kilometern Höhe über der Erde. Zwischen 2002 und 2017 wurden mit den GRACE-Daten monatliche Karten des Geoids erstellt, die Einblicke in die Wasserbewegung und die Veränderung der Eismassen auf der Erde geben. Die 2018 gestartete GRACE-Follow-On-Mission (GRACE-FO) setzte die Zeitreihe fort.

Die GRACE-Missionen sind in der Lage, das Schwerefeld der Erde mit einer Genauigkeit zu messen, die mindestens 100-mal höher ist als bei allen bisher existierenden Methoden, wodurch die bisher verborgenen, feineren Details des Geoids sichtbar werden. Da die TOPEX/Jason-Höhenmesser die Topografie der Meeresoberfläche in Bezug auf diese Referenzfläche messen, bedeuten die hochpräzisen Messungen des Geoids durch GRACE eine genauere Höhenmessung der Topografie der Meeresoberfläche.

SWOT

Die Mission Surface Water Ocean Topography (SWOT) setzt ein Radarinterferometer ein, das nahezu augenblickliche Bilder der Meeresoberflächenhöhe liefert - im Gegensatz zu den bisherigen derzeitigen Altimetern, die nur den Nadir-Punkt, also den Punkt auf der Erde direkt unter dem Satelliten, erfassen. Der Schwerpunkt von SWOT liegt auf den kürzeren Wellenlängen der Meeresoberflächenhöhe, um die feinen Details der Oberflächentopographie des Ozeans beobachten zu können. Darüber hinaus wird SWOT die zeitlichen Veränderungen der Höhe von Landwasserkörpern messen.

Sentinel-6 (Jason-CS)

Die Jason Continuity of Service (Jason-CS)-Mission auf dem Sentinel-6-Satelliten ist eine internationale Partnerschaft zwischen den Vereinigten Staaten und Europa. Jason-CS/Sentinel-6 umfasst zwei identische Satelliten, von denen der erste am 21. November 2020 (Sentinel-6 Michael Freilich) und der zweite im Jahr 2025 (Satellit B) gestartet werden soll. Sentinel-6 Michael Freilich (ehemals Satellit A) wurde im Februar 2020 zu Ehren von Dr. Michael Freilich, Direktor der Earth Science Division der NASA von 2006 bis 2019, umbenannt. Mike Freilich verstarb im August 2020 und hinterließ der Behörde, der Geowissenschaft im Allgemeinen und der Satellitenozeanografie im Besonderen einen enormen Dienst.

Jason-CS/Sentinel-6 erfasst auch hochauflösende vertikale Profile der atmosphärischen Temperatur zur Unterstützung der Wettervorhersage.

|

Altimeter Mission Series

TOPEX/Poseidon

Jason-1

OSTM/Jason-2

Jason-3 GRACE and GRACE-FO Sentinel-6 Sentinel-6 B

SWOT

Quelle: NASA JPL |

Das Jet Propulsion Laboratory der NASA bietet aktuelle Grafiken und Hintergrundinformationen (Ocean Surface Topography from Space).

Die über 10-jährigen Erfahrungen mit den Altimeterdaten haben deren wissenschaftlichen Einsatzbereich deutlich erweitert. Hier ist eine Liste der Ziele aufrufbar.

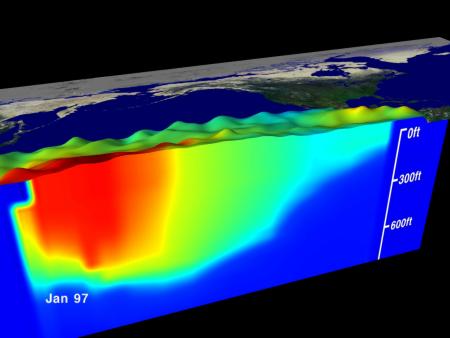

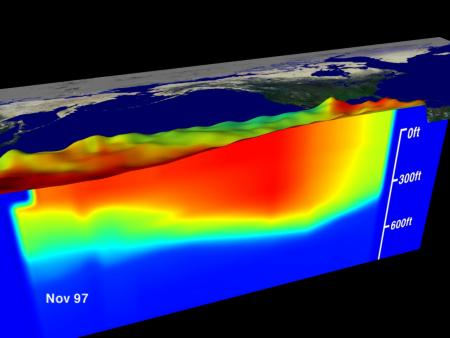

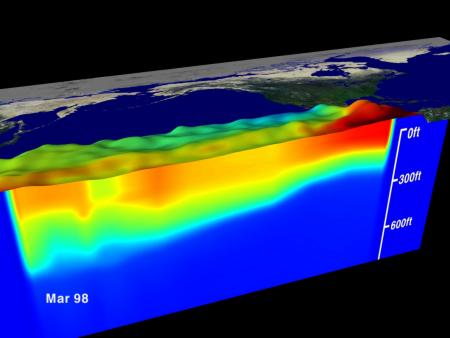

Die folgenden dreidimensionalen Reliefkarten zeigen den Pazifik in seinem neutralen Zustand und während eines El Niño-Ereignisses. Die Wasseroberflächentopographie wurde mit Hilfe von TOPEX/POSEIDON ermittelt.

|

Neutraler Zustand des Pazifiks Farb-Legende: rot = 30 Grad Celsius - blau = 8 Grad Celsius |

|

Zustand während der El Niño-Phase |

|

Zustand bei der ausklingenden El Niño-Phase Quelle: NASA Earth Observatory |

Beim neutralen Zustand (Abb. oben) ist ein scharf begrenzter Warmwasserkörper im westlichen Drittel des Pazifik zu erkennen. Gleichzeitig ist dort der Meeresspiegel als Folge der geringeren Dichte des warmen Wasserkörpers erhöht. Die Thermokline - im Bild der Übergang zwischen dem dunklen Blau unten und dem darüber liegenden Türkis - steigt vom zentralen Teil des Pazifiks nach Osten hin steil an. Ihre hohe Lage vor der südamerikanischen Küste ist Beleg für das dort stattfindende Upwelling.

Die El Niño-Situation zeigt eine Ostwärtsverlagerung des Warmwasserkörpers im Rahmen einer Kelvin-Welle. Der Meeresspiegel ist im östlichen Pazifik um bis zu 34 cm erhöht, die Thermokline zeigt sich deutlich abgeflacht.

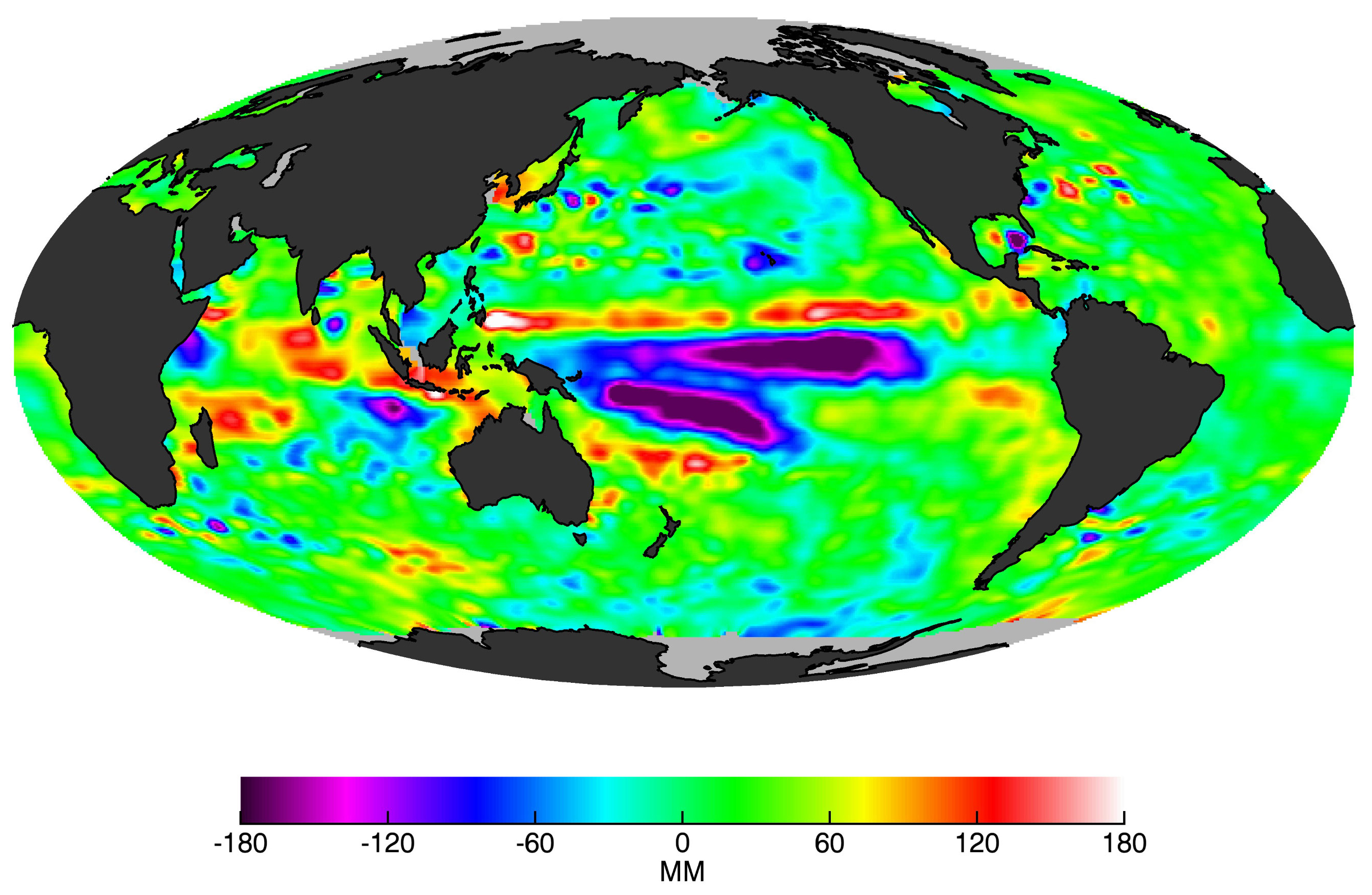

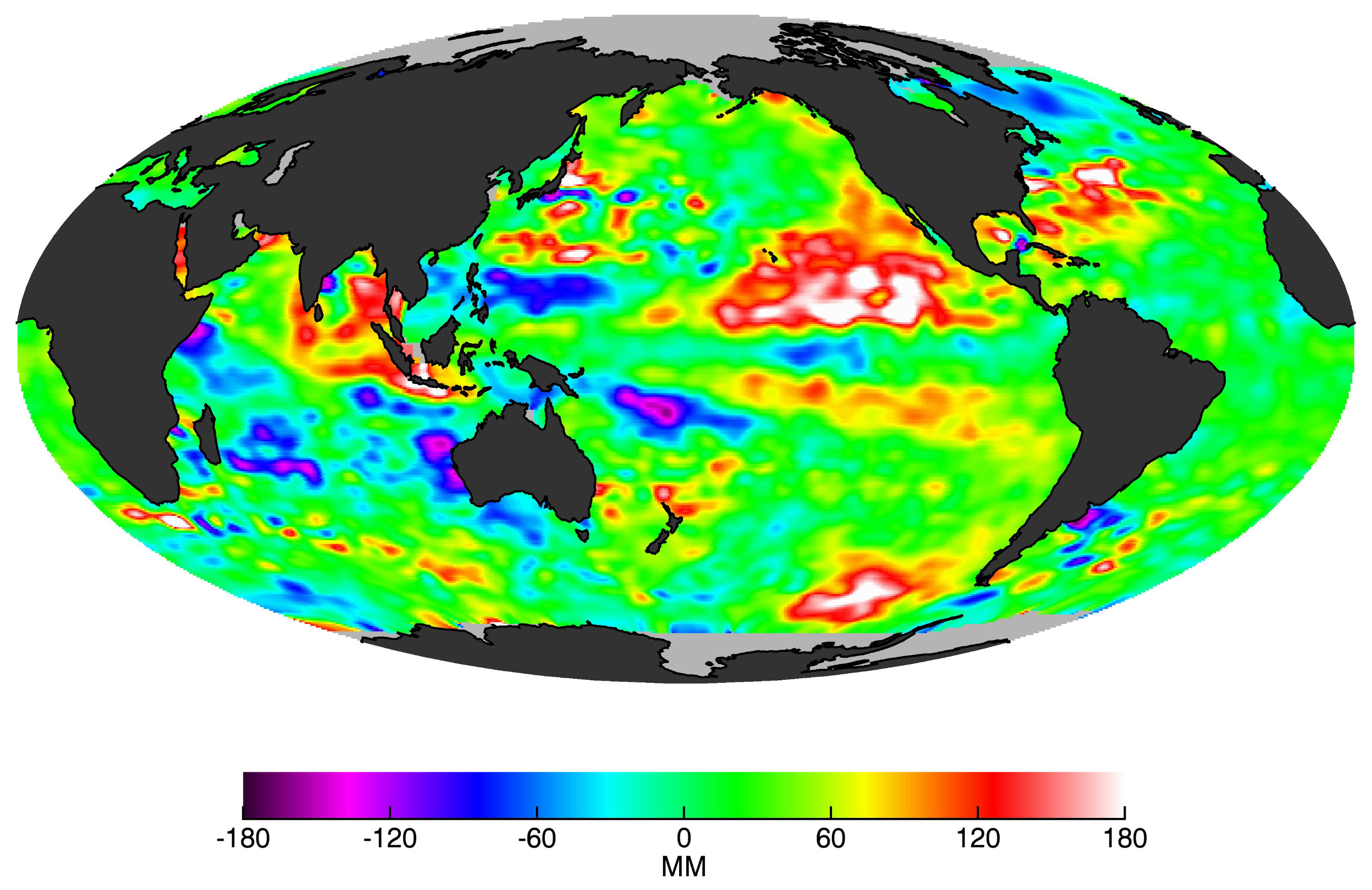

Die beiden folgenden Bilder ermöglichen den Vergleich der Anomalien der Meereshöhen (SSH) während der El Niño-Ereignisse von 1997-1998 (Peak im November 1997) und 2015-2016 (Peak im Januar 2016). Das Bild von 1998 (links) stammt vom Satelliten TOPEX/Poseidon, das Bild von 2016 (rechts) vom Satelliten Jason-2.

Der jüngere El Niño dauerte länger als die Episode von 1997/98 und umfasste ein größeres Gebiet. Ansonsten waren die beiden ähnlich, aber keineswegs identisch, wie gewöhnlich gab es Unterschiede beim zeitlichen Ablauf und bei den Auswirkungen. Man muss sich auch bewusstmachen, dass es 2014/15 einen schwachen zentralpazifischen Niño gab, sodass der starke El Niño von 2015/16 eine Starthilfe hatte. Wenn man die beiden Bilder vergleicht, sieht man, dass der tropische Ostpazifik nördlich des Äquators im Juli 2016 noch immer ein großes Gebiet mit anomal positiven (wärmeren) Werten besitzt. Der Fußabdruck von El Niño ist noch stark.

|

TOPEX/Poseidon |

Jason-2 |

|

Die Daten zu diesen Bildern wurden von den Missionen TOPEX/Poseidon und Jason-2 aufgenommen. |

|

Weitere Informationen:

- Ocean Surface Topography - 2 kurze Einführungen in die Thematik von NASA Science Earth und NASA JPL PODAAC

- Altimetrie - Einführung von CNES / AVISO +

- S. Schöttle (1997): Untersuchungen über die Meereshöhenvariabilität in den tropischen Ozeanen von 1992 bis 1995 unter Verwendung von Radar-Altimeterdaten des TOPEX/POSEIDON-Satelliten.

- Ocean Surface Topography from Space (NASA JPL)

Im Kapitel 'Aktueller Zustand des Pazifiks' befinden sich Links zu Webseiten mit Karten der aktuellen Meeresoberflächenhöhen.

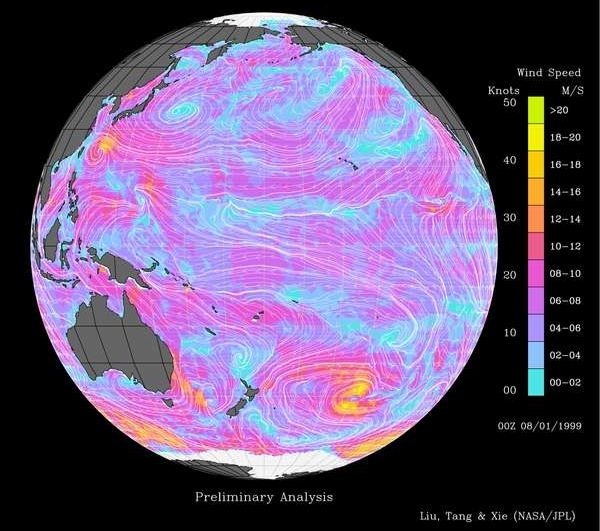

Messung von Windvektoren mit Scatterometern

Neben den beiden Parametern Meeresoberflächentemperatur und Meeresspiegel gehören Veränderungen der Meereswinde zu den wichtigsten Faktoren, die den Einfluss von ENSO auf das Erdsystem belegen. So gelten auf Meereshöhe anomal nach Osten wehende Winde im tropischen West- und Zentralpazifik als Vorläufer und als Hauptmotor von El Niño-Ereignissen.

Ein auf einem japanischen Satelliten basiertes Radarinstrument der NASA stellte von 1996-97 Daten über weltweite Windsysteme bereit. Danach erlitt der Trägersatellit ADEOS (Advanced Earth Observing Satellite) einen Stromausfall. Dieses Scatterometer (NSCAT) genannte Radar arbeitete im Mikrowellenbereich. Es konnte Wolken durchdringen, um durch Informationen über die Meeresoberfläche Aussagen über Windgeschwindigkeit und -richtung zu machen.

|

|

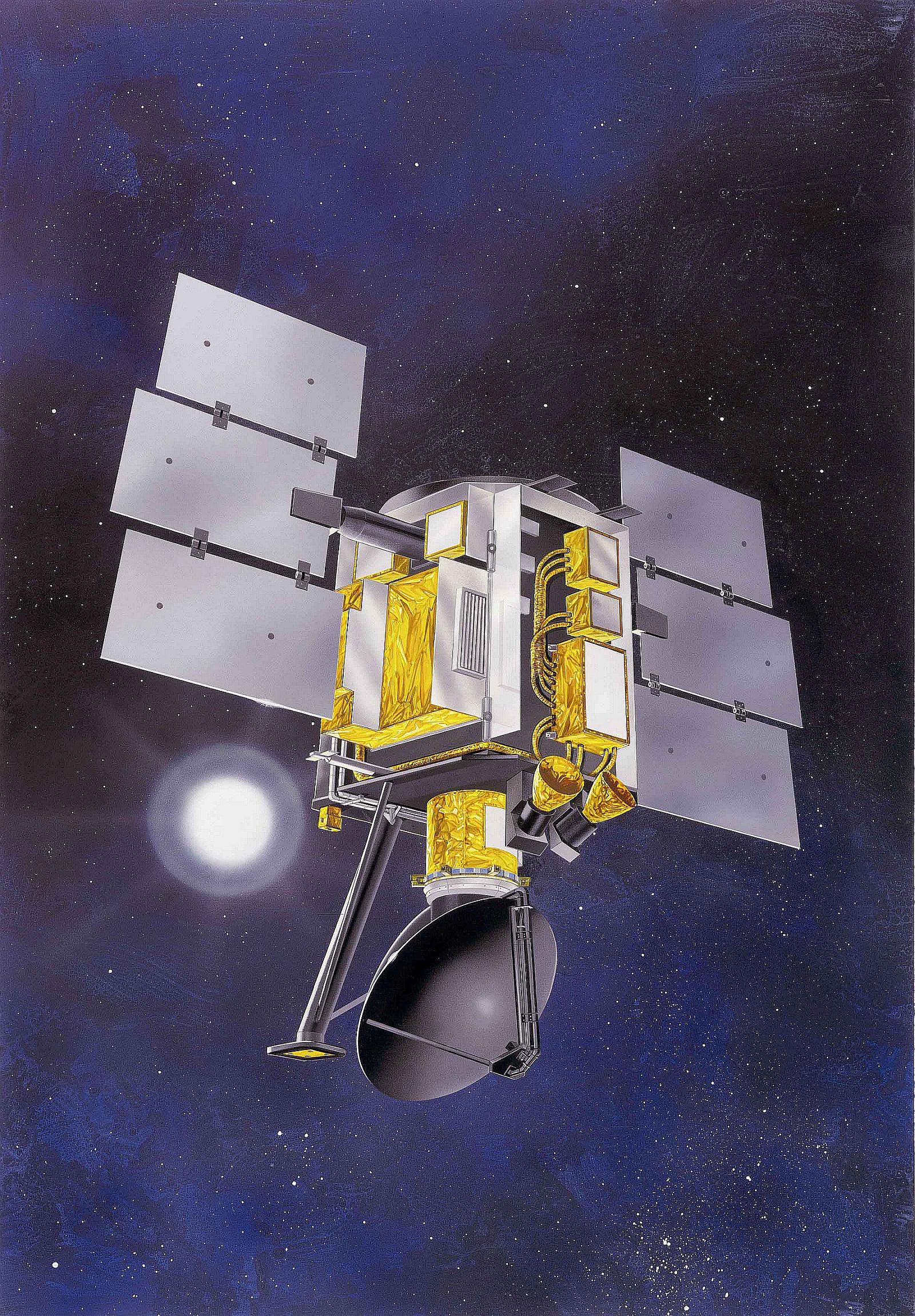

QuikSCAT Links: Start einer Titan II Trägerrakete mit dem QuikSCAT-Satelliten in Vandenberg/Cal. am 19.6.1999 Rechts: QuikSCAT-Satellit auf seiner elliptischen Umlaufbahn mit ihrer max. Höhe von 800 km Quelle: NASA |

Seit 1999 war das NSCAT-System ersetzt durch das auf dem QuikSCAT-Satelliten (seit 2009 inaktiv) installierte SeaWinds-System. Es arbeitete ebenfalls mit einem Scatterometer. Die SeaWinds-Antenne sendete Mikrowellenimpulse mit einer Frequenz von 13,4 Gigahertz aus. Neben den Winddaten lieferte das Gerät auch Informationen über Wellen, Strömungen, Polareiseigenschaften und andere Phänomene. Das Gerät sammelte Daten von einem 1.800 km breiten Streifen, wobei es täglich 400,000 Messungen vornahm und 90 % der Erdoberfläche bestrich. Die SeaWinds-Daten werden sowohl für die Seewettervorhersage genutzt, wie auch für Vorhersage-Modelle. Wissenschaftler versprechen sich von ihnen wesentliche Verbesserungen bei kurzfristigen Warnmeldungen und bei kurz- bis langfristigen Vorhersagen.

|

Windgeschwindigkeiten und -richtungen über dem Pazifik am 1.8.1999, aufgenommen mit dem SeaWinds-Radar Die starken Oberflächenwinde des Taifuns Olga (gelbe Spirale) können im Chinesischen Meer vor Südkorea ausgemacht werden. Der östlichen Nordpazifik wird von einem beständigen Hochdrucksystem beherrscht, dessen antizyklonale Fließrichtung starke Winde hervorbringt, die parallel zu den Küsten Kanadas und der USA strömen. Drei intensive Wintersturmzentren sind nördlich der Antarktis zu erkennen. Das Radarinstrument der NASA zur Beobachtung des Ozeans, SeaWinds, hat die Wut des Taifuns Olga eingefangen, der im August 1999 im Chinesischen Meer hohe Windgeschwindigkeiten von mehr als 50 Knoten (57 Meilen pro Stunde) aufwies und sintflutartige Regenfälle über Südkorea, Nordkorea und andere Küstengemeinden in Südasien brachte. Quelle: NASA JPL |

Ein Nachfolgeprojekt mit einem SeaWinds-System wurde an Bord des japanischen ADEOS-II im Jahr 2002 ins All gebracht, das allerdings nach kurzer Zeit als Folge eines Sonnensturms ausfiel.

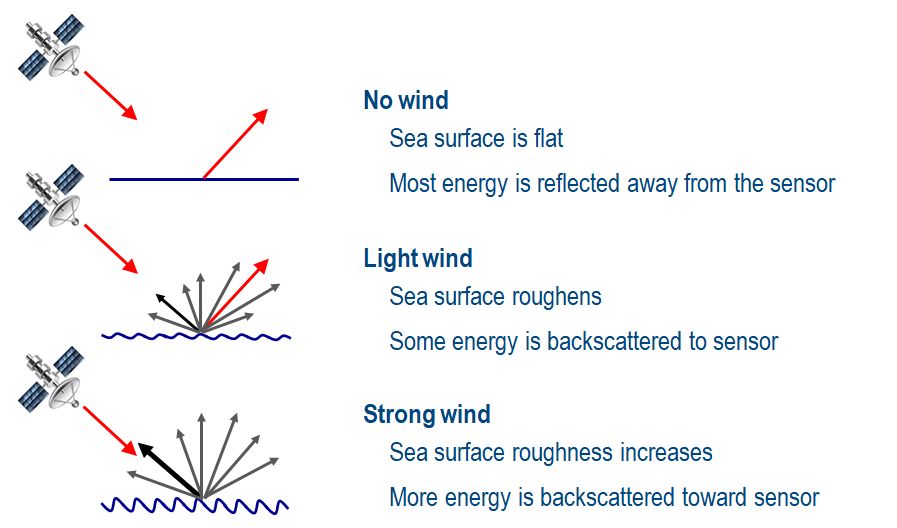

Scatterometer, wie auch das verwandte Synthetic Aperture Radar (SAR) senden Mikrowellenimpulse aus und messen die Intensität des Signals, das zum Satelliten zurückkehrt, nachdem es an der Meeresoberfläche reflektiert wurde. Die Stärke des zurückgekehrten Impulses gibt einen Hinweis auf die Rauhigkeit der Meeresoberfläche. Eine rauhe Meeresoberfläche schickt einen schwachen Impuls zurück, da die Wellen an der Meeresoberfläche die Energie des Mikrowellenimpulses in verschiedene Richtungen streuen. Die Streuung vermindert die Energiemenge, die von dem Satelliten dann empfangen wird. Andererseits schickt eine glatte Meeresoberfläche einen starken Impuls zurück, weil der Streueffekt der Wellen gering ist. Die Oberflächenrauhigkeit ist abhängig von der Windgeschwindigkeit.

Scatterometer und SAR messen die Richtung in der sich die Wellen in Bezug zum Satelliten bewegen. Die Richtung der Wellen in Bezug auf den Radarimpuls wirkt sich auf die Polarisation des zurückgesandten Signals aus. Mit Hilfe dieser Grundlagen und mit mathematischen Formeln kann die Bewegungsrichtung der Wellen bestimmt werden.

|

Scatterometrie - Grundprinzip Die Scatterometrie nutzt die Oberflächenrauhigkeit und den Pulswinkel, um Windrichtung und -geschwindigkeit zu ermitteln. Die Rückstreuung von Scatterometerimpulsen ist empfindlich für die Rauheit der Meeresoberfläche, die in Windgeschwindigkeit umgerechnet werden kann.

Die Rückstreuung ist auch empfindlich für die Impulsrichtung im Verhältnis zur Windrichtung. |

Aktuell messen ASCAT-Instrumente an Bord der europäischen MetOp-Satelliten Windgeschwindigkeit und -richtung über den Ozeanen.

Nach dem Ausfall des QuikScat-Satelliten installierte die NASA im September 2014 als rasche und kostengünstige Zwischenlösung das RapidSCAT-Instrument auf der Raumstation ISS.

El Niño-Ereignisse haben beträchtliche Auswirkungen auf das gesamte Erdsystem, und gleichzeitig werden sie in hohem Maße durch die beobachtbare Veränderung von drei Parametern des Systems erfasst: die Meeresoberflächentemperatur (SST), die Höhe der Meeresoberfläche (SSH) und die oberflächennahen Meereswinde. In der Tat sind die charakteristischen ostwärts wehenden Winde im tropischen West- und Ostpazifik sowohl Vorläufer als auch Hauptantriebskraft von El Niño-Ereignissen.

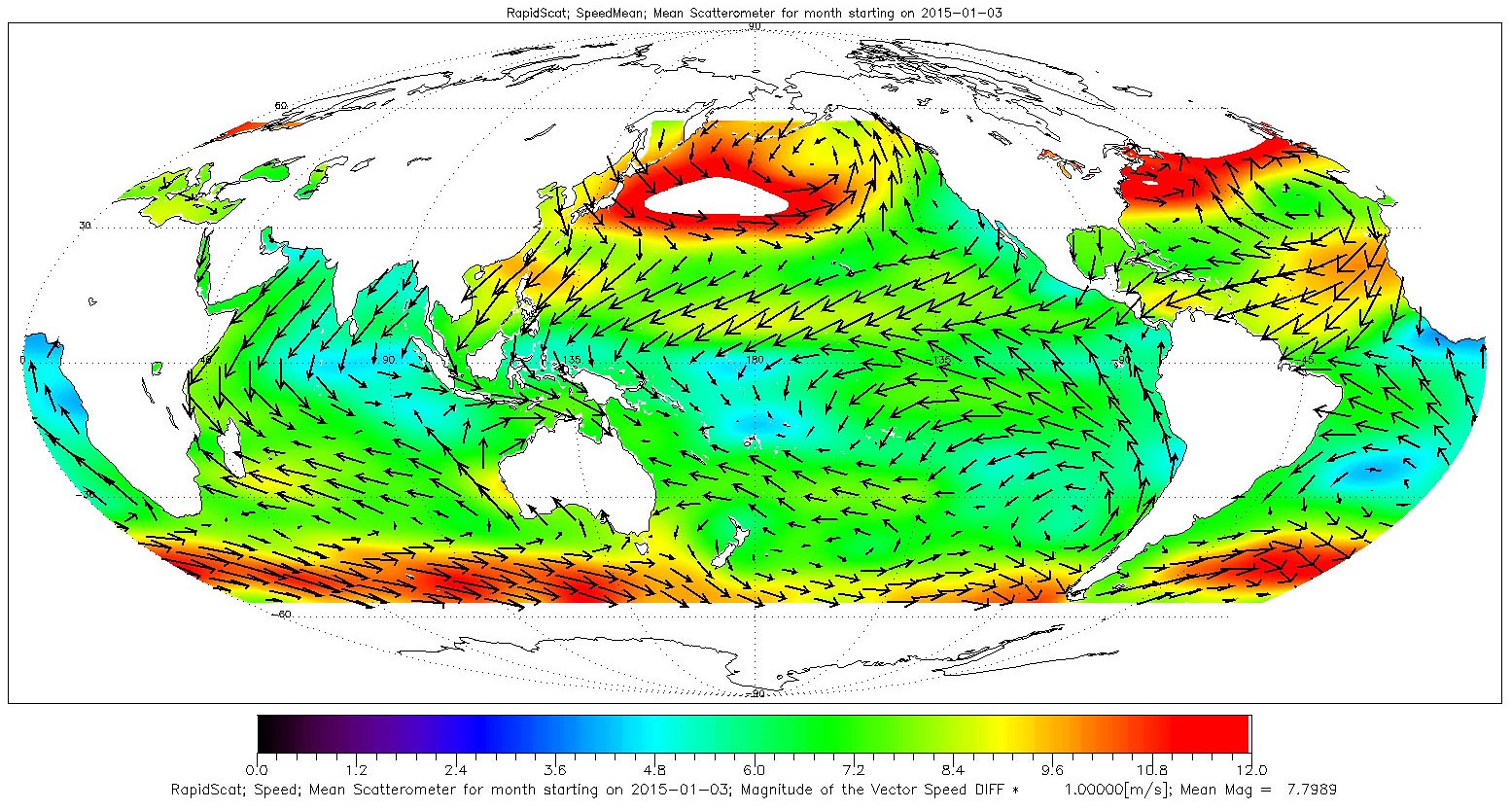

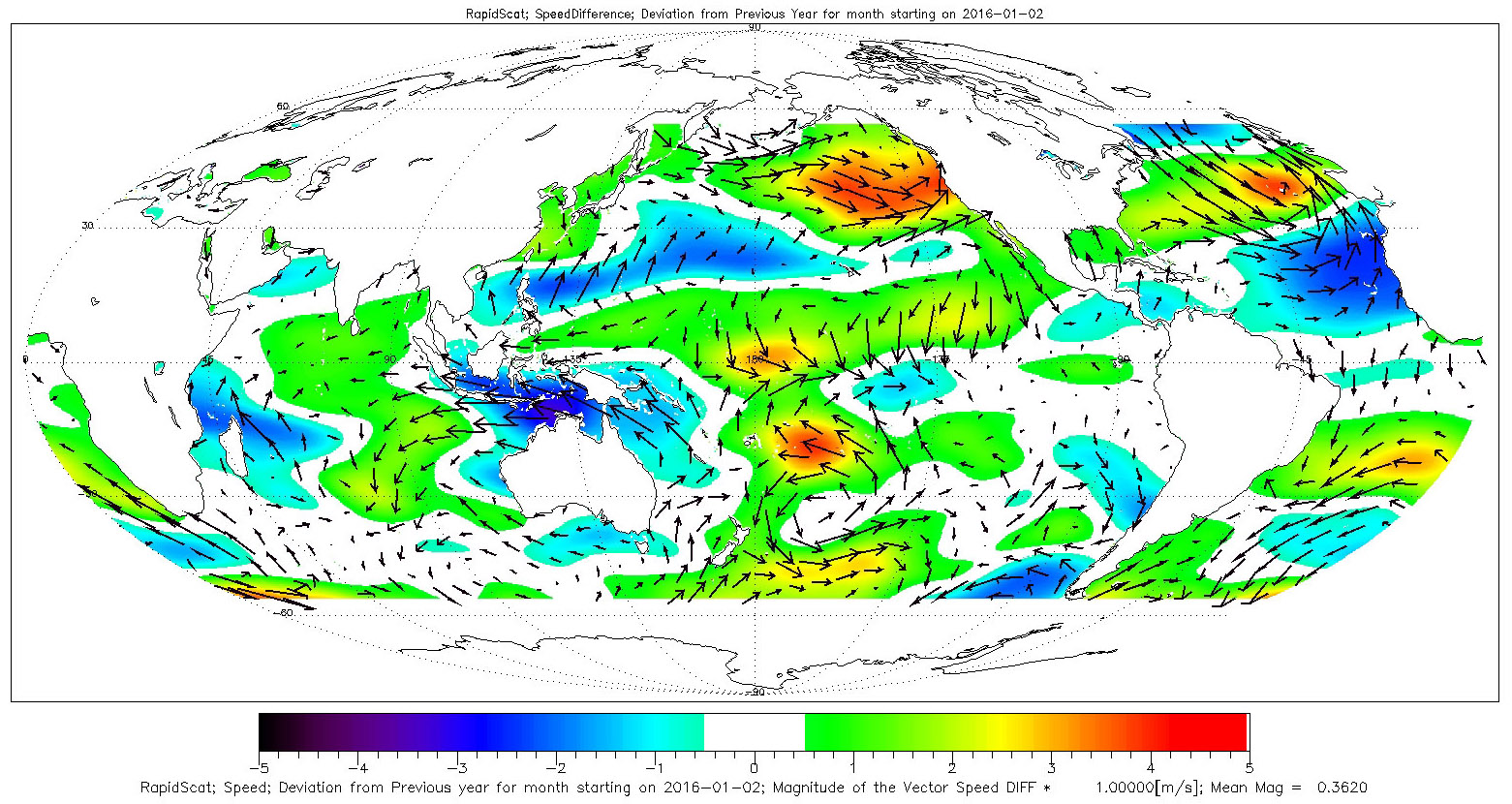

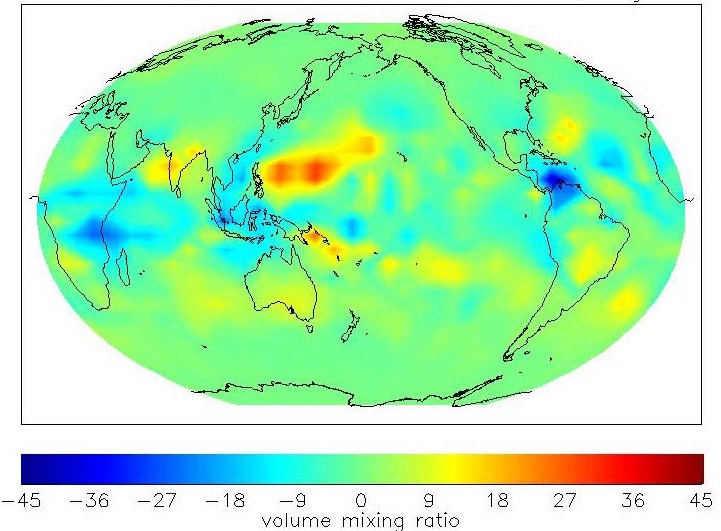

Die folgenden Abbildungen zeigen die von NASAs RapidSCAT beobachteten oberflächennahen Winde über den Weltmeeren. Die linke Karte zeigt die durchschnittlichen Windverhältnisse in der Zeit vom 3. Januar 2015 bis zum 3. Februar 2015. Die rechte Karte zeigt die Windanomalien im Januar 2016, bezogen auf 2015. In beiden Fällen stellen die Farben die Windgeschwindigkeit dar, die Pfeile geben die Richtung der mittleren bzw. anomalen Winde an. Das El Niño-Signal ist in der rechten Abbildung durch die ostwärts wehenden anomalen Winde im tropischen West- und Zentralpazifik deutlich erkennbar. Das El Niño-Signal ist auch deutlich in der anomal stärkeren Konvergenz im tropischen Ostpazifik, erkennbar an den dort stärkeren äquatorwärtigen Winden.

|

RapidScat |

RapidScat |

|

Die Daten zu diesen Bildern wurden vom auf der Raumstation basierten Instrument RapidScat (2014-2016) aufgenommen. |

|

Zusätzlich zu den Scatterometer-Messungen, die aktive Mikrowellen-Systeme einsetzen, werden die Geschwindigkeiten bodennaher Winde auch von einem passiven Mikrowellensensor an Bord eines militärischen Wettersatelliten gemessen. Das Gerät trägt die Bezeichnung "Special Sensor Microwave/Imager" (SSM/I).

Windmessungen mit Hilfe von "Windprofilern"

Im Pazifik wurde ein Netz von Windprofilern auf 6 abgelegenen Inseln installiert (Trans-Pacific Profiler Network, TPPN). Die Ortswahl soll die Datenlücken im tropischen Pazifik schließen helfen. Die Messergebnisse können für die tägliche Wettervorhersage verwendet werden, wie auch für das Verständnis und die Vorhersage von Phänomenen wie El Niño, die die jahresübergreifende Klimavariabilität in weiten Teilen der Erde beeinflussen. TPPN wird seit 2004 kostenbedingt als Programm nicht mehr weitergeführt, wohl aber gibt im pazifischen Raum auch künftig an mehreren, auch neu hinzugekommenen Standorten diese Technologie.

|

Transpazifisches Windprofiler-Netz Das inzwischen aufgelöste TPPN war ein Netzwerk von Windmessinstrumenten an tropischen Inselstandorten, das sich über das Pazifikbecken erstreckte.

Quelle: |

|

Gelände der Wind-Profiler-Station in Biak, Indonesien

Quelle: NOAA Aeronomy Laboratory |

Windprofiler sind 50 MHz und 915 MHz Doppler-Radargeräte, die Vertikalprofile von horizontalen und vertikalen Luftbewegungen erstellen können. In Abhängigkeit von der Gerätefrequenz und den atmosphärischen Bedingungen können sie die Troposphäre bis in eine Höhe von 15 km beobachten. Zusätzlich können Informationen über Niederschlag und atmosphärische Turbulenzen gewonnen werden.

Die Windprofiler liefern direkte Messungen, die verwendet werden können um Schwerewellen, Konvektion und andere Prozesse zu untersuchen. Und sie liefern ohne Zusatzkosten kontinuierlich Daten. So dienen sie dem besseren wissenschaftlichen Verständnis

- ozeanischer Grenzschichtwinde,

- des Feuchtigkeitshaushaltes der Luftschichten,

- der täglichen, jährlichen und jahresübergreifenden Variabilität der atmosphärischen Zirkulation

- sowie des atmosphärischen Wärmehaushaltes.

Ermittlung von Meeresoberflächentemperaturen mit Radiometern

Das in vier NOAA Satelliten installierte, vier- bzw. fünfkanalige Advanced Very High Resolution Radiometer (AVHRR) liefert Daten über die Temperatur der Meeresoberfläche. Es handelt sich um einen Breitband-Scanner. Der erste AVHRR-Sensor wurde im Oktober 1978 mit dem TIROS-N-Satelliten (Satellitenserie der NOAA) ins All befördert und hatte 4 Kanäle. AVHRR/2 folgte im Juni 1981 auf der NOAA-7-Plattform und hatte bereits 5 Kanäle. "Vierkanalig" bedeutet, dass das Instrument in vier verschiedenen Bereichen der sichtbaren, nahinfraroten und thermisch-infraroten Teile des Spektrums "sieht". Der fünfte Kanal neuerer Modelle verbessert die Messung der SST, indem er Korrekturen für die verzerrende Wirkung des atmosphärischen Wasserdampfes liefert.

Die dritte Version AVHRR/3 (mit nunmehr 6 Kanälen) startete im Mai 1998 mit NOAA-15 und findet sich auch auf dem aktuellen NOAA-19. Ein weiteres AVHRR/3-Instrument wurde im Oktober 2006 mit dem Satelliten Metop-A (EUMETSAT) in den Orbit gebracht. Auch auf den Folgesatelliten dieser Serie ist das Instrument installiert, so dass eine längerfristige Verfügbarkeit gesichert ist. Die Erfahrungen im operationellen Betrieb mit dem MODIS-Sensor an Bord der NASA-Satelliten Terra und Aqua führte zur Entwicklung von VIIRS, dem Nachfolger von AVHRR. VIIRS ist gegenwärtig an Bord des Satelliten Suomi National Polar-orbiting Partnership (frühere Bezeichnung NPOESS ) im Einsatz und wird auch an Bord des Joint Polar Satellite System im Spätjahr 2017 eingesetzt.

|

Mögliche El Niño-Telekonnektionen:

Quelle: NASA (R.o.) |

Die Graphik zeigt das frühe Stadium des El Niños 1997/98 und mögliche Telekonnektionen. Die weißen Pfeile stellen Anomalien der mit NSCAT ermittelten Oberflächenwinde dar, die Farben repräsentieren Anomalien der Meeresoberflächentemperaturen, die mit AVHRR gemessen wurden. Beide Parameter stellen die Situation für die letzte Woche im Mai 1997 dar. Auffällig sind die anomalen Westwinde im äquatorialen Westpazifik, die anomalen Südwinde entlang der mexikanischen und kalifornischen Küste sowie die Unterdrückung der äquatorialen und küstennahen Auftriebswässer und die nachfolgende anomale Erwärmung. Erkennbar ist eine "Pineapple Express" genannte Windströmung, die Feuchtigkeit aus der Gegend um Hawaii an die kalifornische Küste transportiert. Die Verstärkung der außertropischen zyklonalen Fließrichtung führt zu einem Zustrom von ungewöhnlich warmen Wassermassen.

Im Kapitel 'Aktueller Zustand des Pazifiks' befinden sich Links zu Homepages mit Karten der aktuellen Meeresoberflächentemperaturen.

(s.a. Definition von Radiometer im Lexikon)

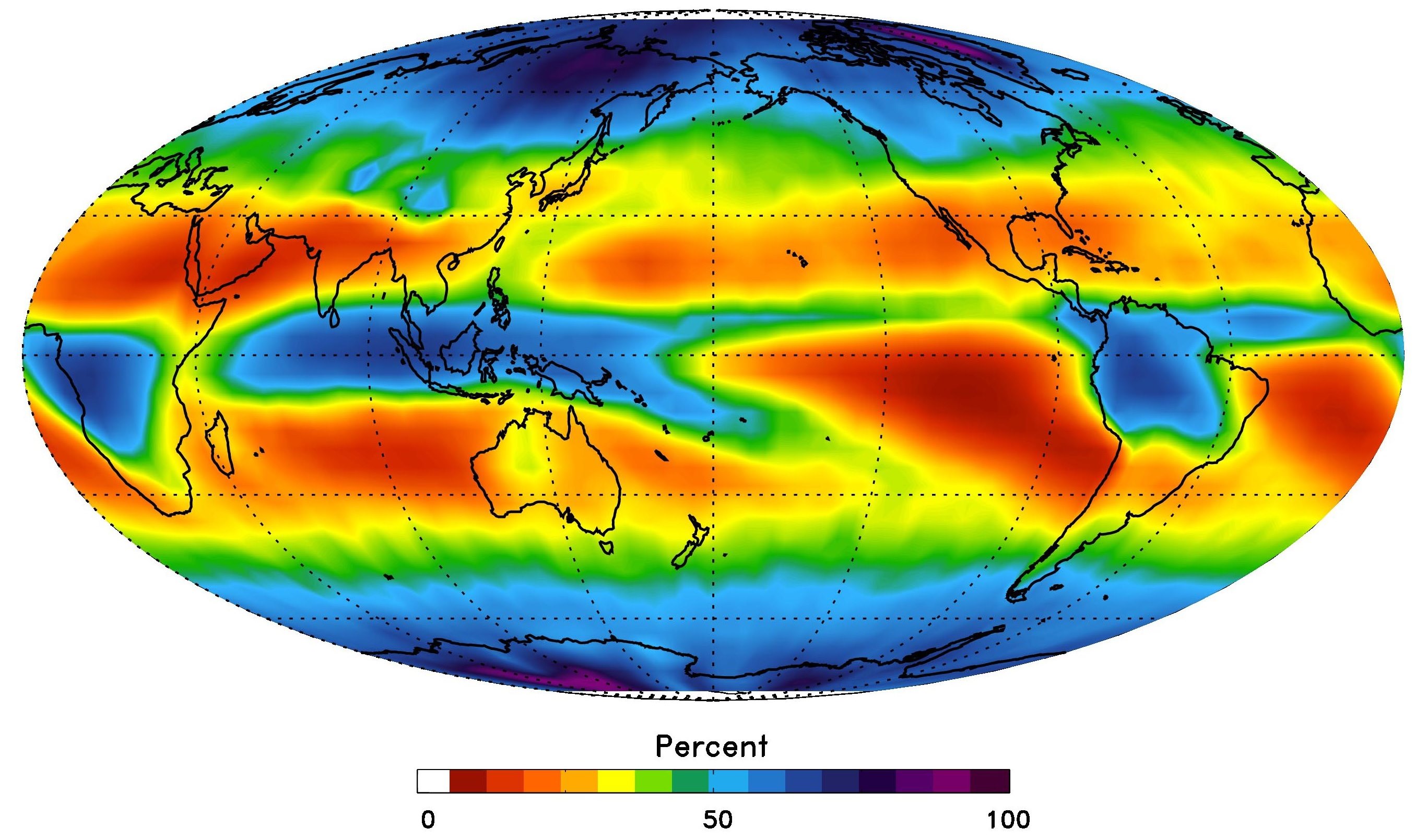

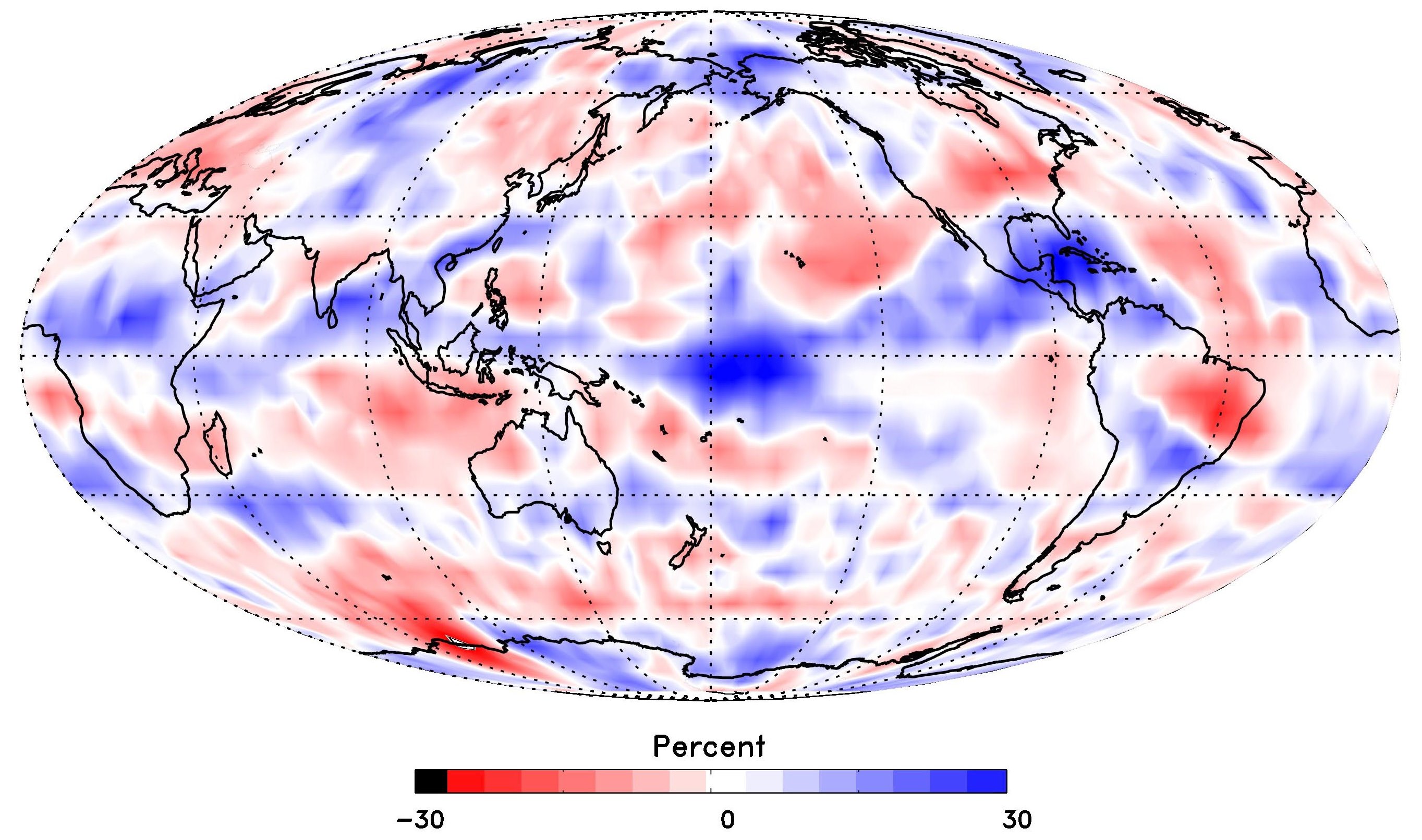

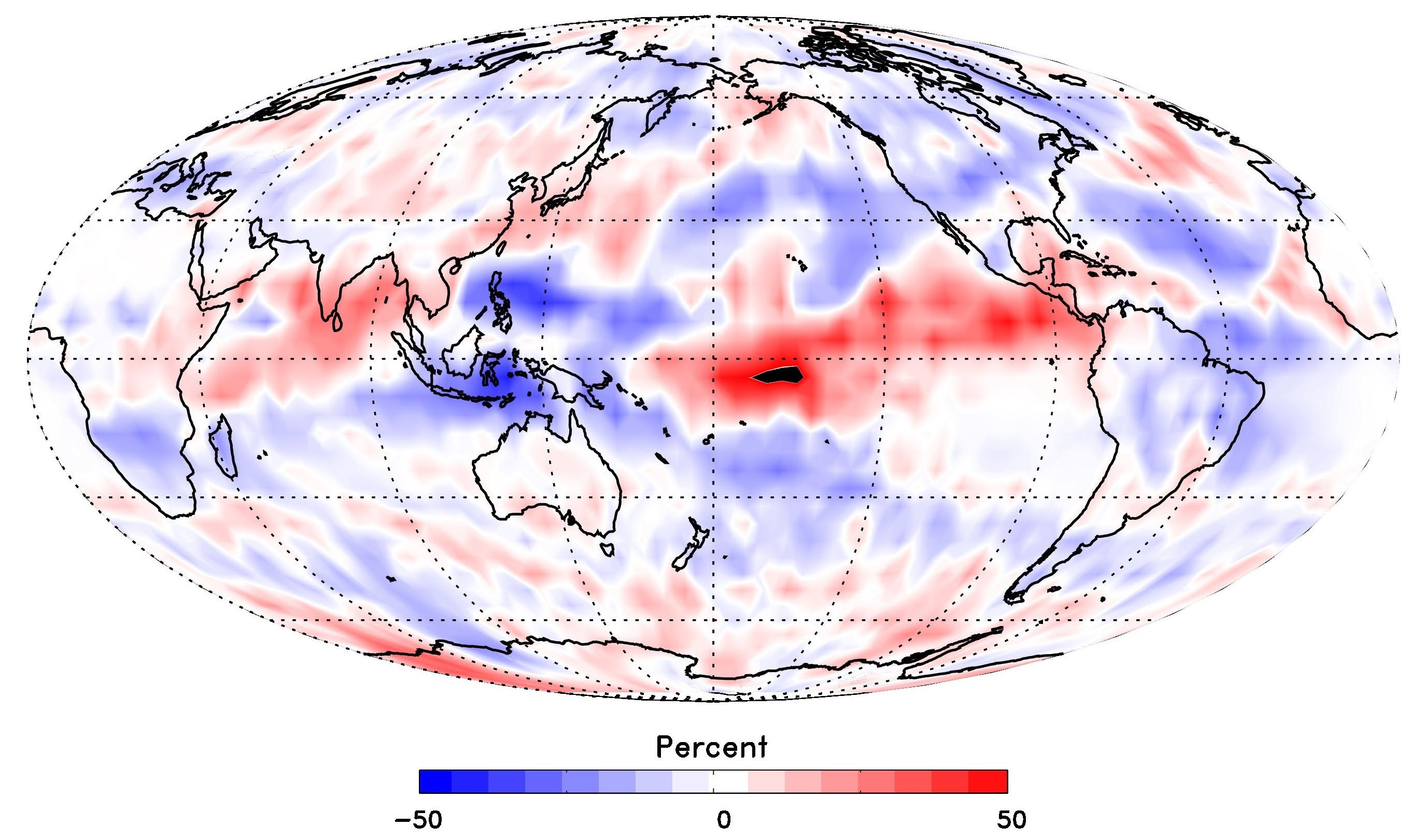

Messung der Relativen Luftfeuchte

Die Relative Luftfeuchte im 500 hPa-Niveau, welches sich vertikal etwa in der Mitte der für das Wettergeschehen wichtigen Troposphäre befindet, wird als Maß verwendet um in den folgenden Abbildungen Wechsel im atmosphärischen Feuchtigkeitsgehalt hervorzuheben. Die Tropen und die Sturmbahnen der Mittelbreiten sind typischerweise feucht, während die dazwischen liegenden Subtropen trockenere Luft aufweisen (Abb. links). Der El Niño 2015/16 hat im tropischen und subtropischen Ostpazifik zu einer deutlich höheren Relativen Luftfeuchte geführt und gleichzeitig zu viel trockeneren Bedingungen über Indonesien und Südostasien, was mit dem gleichzeitigen Rückgang der Niederschläge, den Dürrebedingungen und den häufigen Bränden übereinstimmt (Abb. rechts).

|

Relative Humidity at 500 hPa |

Relative Humidity at 500 hPa |

|

Die Daten zu diesen Bildern wurden vom Instrument Atmospheric Infrared Sounder (AIRS) auf dem NASA-Satelliten Aqua aufgenommen. |

|

Weitere Informationen:

Beobachtung der Cirrus-Wolken

Cirrus-Wolken sind Eiswolken, die in der oberen Troposphäre zwischen 5 und 13 km auftreten. Ihr Auftreten ist z.B. verbunden mit tropischer Konvektion und Winterstürmen in Kalifornien. Die Veränderungen in der Häufigkeit von Cirrus-Wolken ähnelt dem Muster mit dem sich die Relative Feuchte und die ausgehende Langwellenstrahlung ändern. Bezogen auf die Abbildungen unten (November 2015) ist anzumerken, dass es in den Monaten davor zu einer sehr starken Zunahme von Cirrus-Wolken über dem östlichen Pazifik und über dem südlichen Drittel der USA und über Mexiko gekommen ist und gleichzeitig zu einem aktiveren Subtropenjetstream, was sehr typisch für einen starken El Niño ist.

|

Cirrus Cloud Frequency |

Cirrus Cloud Frequency |

|

Die Daten zu diesen Bildern wurden vom Instrument Atmospheric Infrared Sounder (AIRS) auf dem NASA-Satellit Aqua aufgenommen |

|

Weitere Informationen: El Niño's effect on Cirrus clouds (NASA JPL)

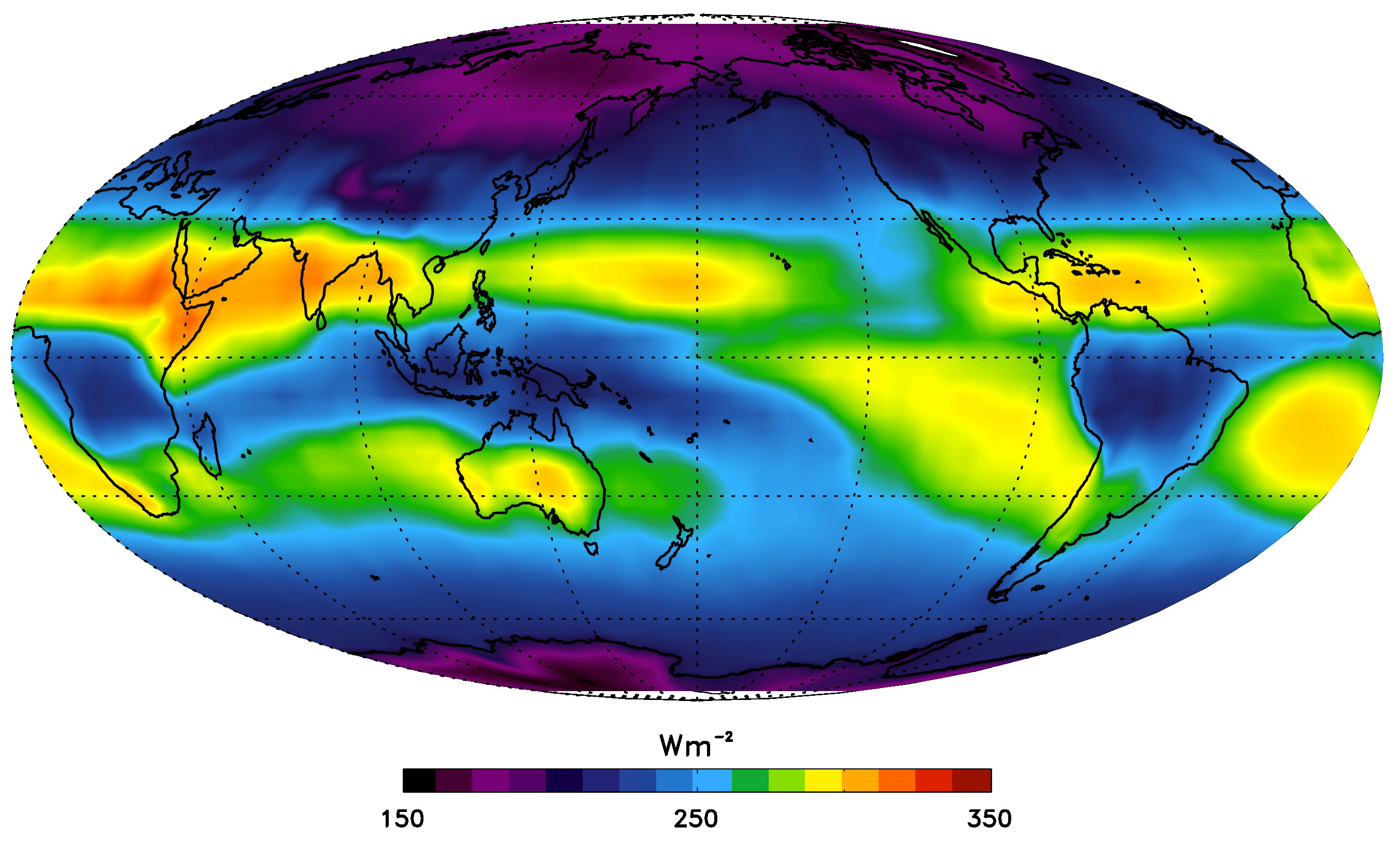

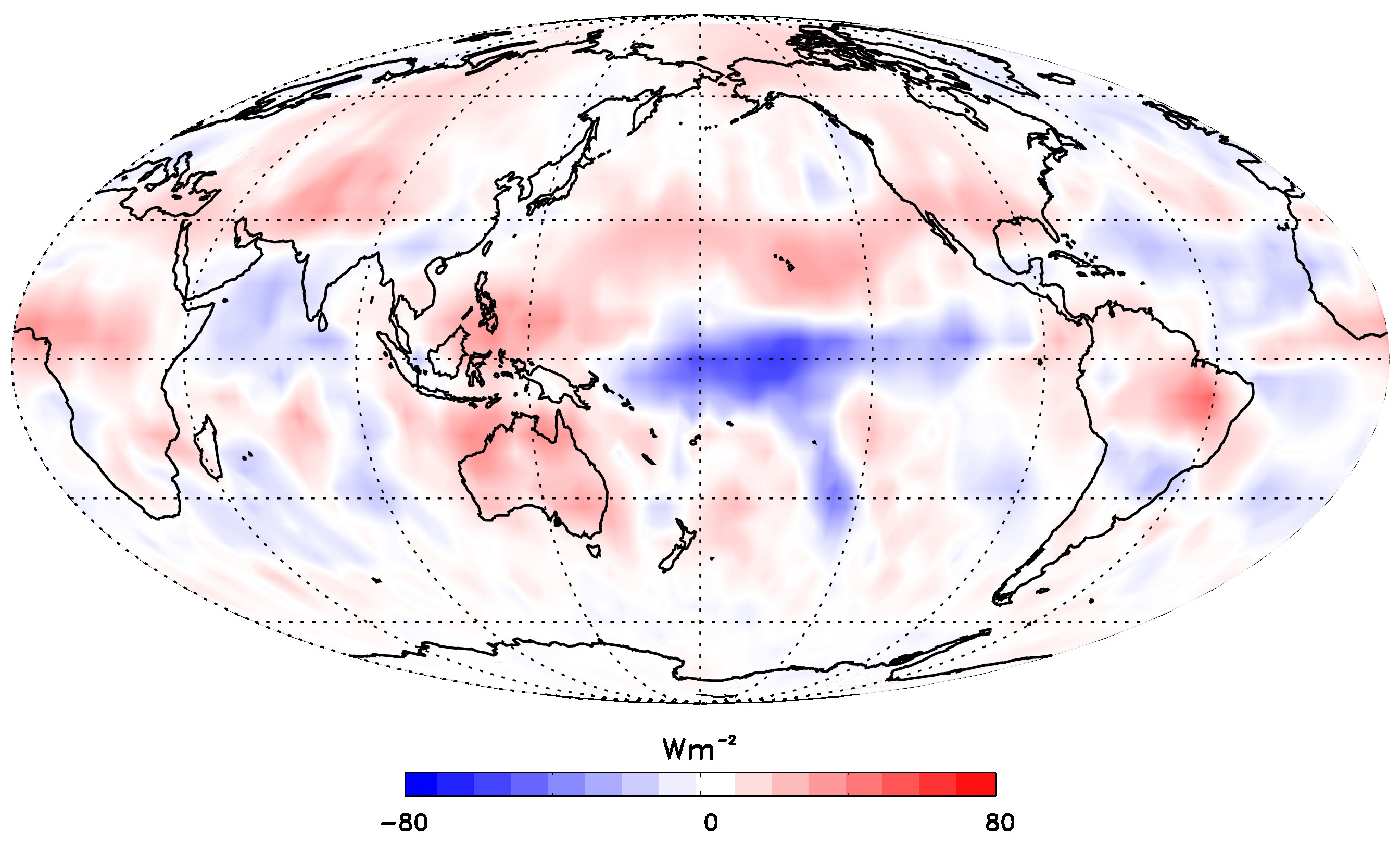

Messung der Outgoing Longwave Radiation mit Radiometern

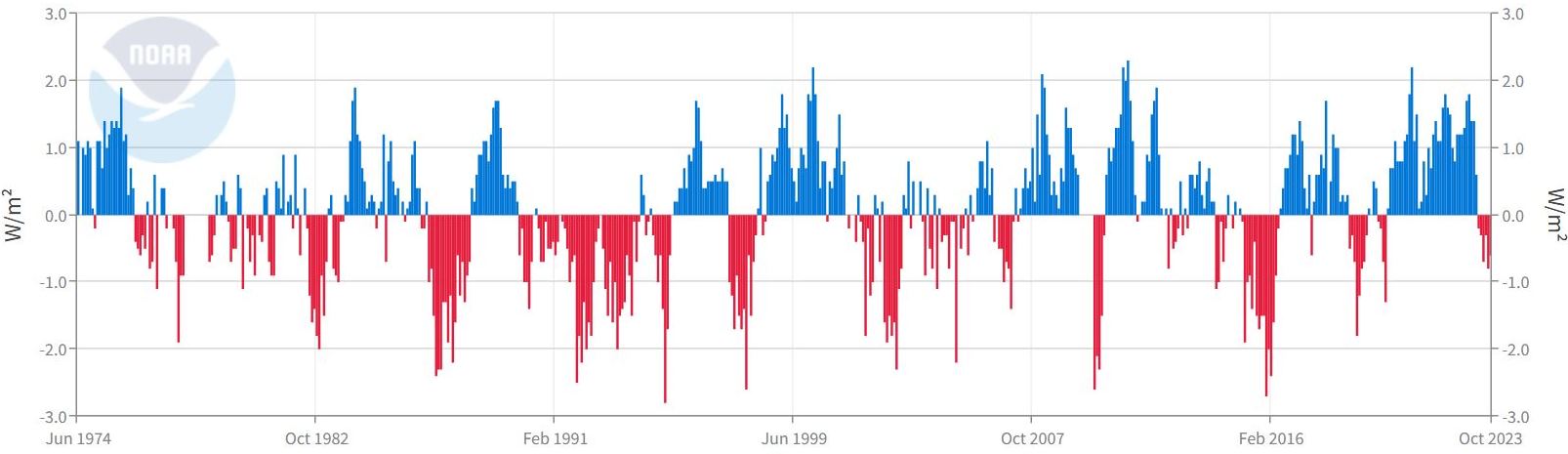

Beobachtungsdaten der ausgehenden Langwellenstrahlung (Outgoing Longwave Radiation, OLR) an der Obergrenze der Atmosphäre (Top of the Atmosphere, TOA) werden vom Advanced Very High Resolution Radiometer (AVHRR) an Bord der polumlaufenden NOAA-Wettersatelliten ermittelt. Die Datenaufnahme konzentriert sich auf äquatoriale Gebiete von 160° O bis 160° W. Die Rohdaten werden in einen standardisierten Anomalie-Index konvertiert. Negative (Positive) OLR zeigen verstärkte (unterdrückte) Konvektion an und damit stärkere (geringere) Wolkenbedeckung, was typisch für El Niño- (La Niña-) Episoden ist. Verstärkte (geringere) konvektive Aktivität im zentralen und östlichen äquatorialen Pazifik weist auf höhere (niedrigere) und kältere (wärmere) Wolkenoberseiten hin, welche entsprechend viel weniger (mehr) Infrarotstrahlung in den Weltraum ausstrahlen.

|

Outgoing Longwave Radiation (OLR)

Die Daten der OLR an der Oberseite der Atmosphäre werden mit dem Instrument AVHRR an Bord der NOAA-Satelliten erfasst. Negative (Positive) OLR weisen auf eine verstärkte (unterdrückte) Konvektion und damit auf eine für El Niño (La Niña)-Episoden typisch dichtere (geringerer) Wolkenbedeckung hin. Mehr (Weniger) konvektive Aktivität im zentral- und ostäquatorialen Pazifik bedeutet höhere (niedrigere), kältere (wärmere) Wolkenoberseiten, die viel weniger (mehr) Infrarotstrahlung in den Weltraum abgeben. Quelle: NOAA |

Weitere Informationen: Climate Prediction Center OLR page

Messung der Outgoing Longwave Radiation mit dem AIRS-Infrarotsounder

Outgoing Longwave Radiation (OLR) oder zu dt. ausgehende Langwellenstrahlung, ist die Thermalstrahlung oder Wärmeenergie, die von der Erdoberfläche und der Atmosphäre in Richtung Weltraum abstrahlt. Die OLR ist abhängig von Temperatur, Luftfeuchte und Wolken, und sie ist gewöhnlich über den subtropischen Wüstenregionen und den subtropischen Ozeanen am größten. Die OLR ist geringer in den höheren Breiten und ind den wolkigen und feuchten Teilen der Tropen. Der El Niño 2015/16 hat eine Verlagerung des üblichen geographischen Musters der OLR bewirkt: Der tropische Zentral- und Ostpazifik verzeichnet reduzierte OLR, verbunden mit verstärkter Konvektion und Feuchtigkeit, wohingegen im tropischen Westpazifik die OLR stark zugenommen hat.

Die OLR-Anomalien sind in den Folgemonaten verschwunden, da sich ab Mai 2016 eine Neutralphase ausgebildet hat. Eine Animation zeigt die mit AIRS auf dem NASA-Satelliten Aqua gemessenen OLR-Anomalien von Januar 2015 bis Juni 2016.

|

All Sky Outgoing Longwave Radiation |

All Sky Outgoing Longwave Radiation |

|

Die Daten zu diesen Bildern wurden vom Instrument Atmospheric Infrared Sounder (AIRS) auf dem NASA-Satelliten Aqua aufgenommen |

|

Weitere Informationen:

Beobachtung von Wasserdampf-Anomalien in der oberen Troposphäre

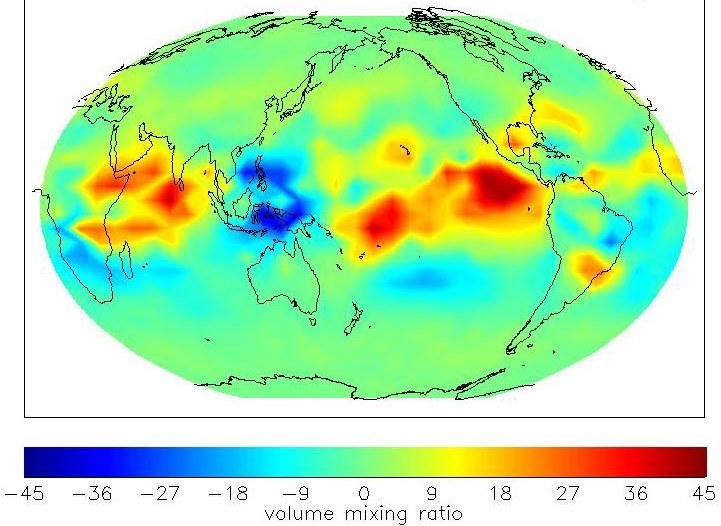

Diese Bilder zeigen die Wasserdampfanomalien in der oberen Troposphäre bei ca. 10 km Höhe jeweils am 7. November 2014 und 2015, bezogen auf 11-jährige Durchschnittswerte. Unter normalen Bedingungen sind die Meeresoberflächentemperaturen des tropischen Pazifik am wärmsten in seinem Westteil, etwa in der Gegend von Indonesien und am kühlsten in seinem Ostteil vor Südamerika. Stürme über den Ozeanen sind eine Folge von warmen SSTs, und Feuchtigkeit von solchen Systemen wird bis in die obere Troposphäre transportiert, wie man dies in den Kartendarstellungen erkennen kann. Die roten Werte zeigen überdurchschnittlich feuchte Bedingungen an und blaue überdurchschnittlich trockene. Die roten Flächen, die sich 2015 über dem Ostpazifik zeigen, aber nicht 2014 belegen, dass die SST sich vor der Küste Süd- und Mittelamerikas erwärmt haben, und dass die obere Troposphäre dank verstärkter tropischer Konvektion feuchter als im Mittel ist. Die Bilder wurden nach Daten des Instruments Microwave Limb Sounder (MLS) an Bord des NASA-Satelliten Aura generiert.

|

Nov, 2014 - 215 hPa H2O Anomaly |

Nov, 2015 - 215 hPa H2O Anomaly |

|

Feuchtigkeitsanomalien in 10 km Höhe nach Messungen des Instruments Microwave Limb Sounder (MLS) auf dem NASA-Satelliten Aura. Die Farben stehen entsprechend der Skala für trockenere, durchschnittliche und feuchtere Bedingungen verglichen mit Durchschnittswerten. Die Darstellung vom 7. November zeigt durchschnittliche Bedingungen. |

Feuchtigkeitsanomalien in 10 km Höhe. Die Farben stehen entsprechend der Skala für trockenere, durchschnittliche und feuchtere Bedingungen verglichen mit Durchschnittswerten. Die Darstellung vom 7. November zeigt Bedingungen unter einem starken El Niño, da die Feuchtigkeit über dem Westpazifik deutlich größer als im Durchschnitt und der Ostpazifik viel trockener als im Durchschnitt ist. |

|

Die Bilder wurden nach Daten des Instruments Microwave Limb Sounder (MLS) an Bord des NASA-Satelliten Aura generiert. |

|

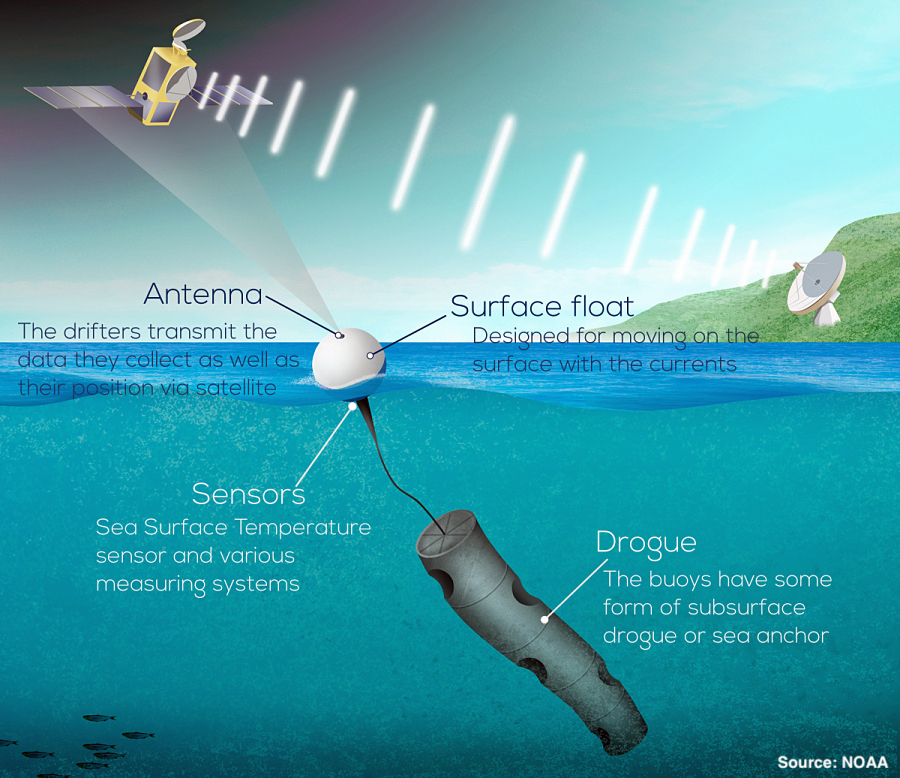

Messung der Meeresoberflächentemperaturen mit Treibbojen

Treibbojen ("drifter", "drifting buoy") sind ozeanographische Instrumente, die aus einem Schwimmer an der Oberfläche bestehen, der an einem Treibanker befestigt ist. Sie liefern wichtige Informationen über den oberen Ozean wie Temperatur, Salzgehalt, Strömungsrichtung und -geschwindigkeit. Dies sind wichtige Grunddaten für die Erstellung von Klimavorhersagemodellen. Viele Drifter besitzen ein Driftsegel/Treibanker (engl. drogue), um die verfälschenden Wind- und Welleneinflüsse zu mindern. Er sorgt also dafür, dass die Drifter dem Wasser mit hoher Genauigkeit folgen. Oberflächenwellen, die häufig mehrere Meter übersteigen, und der Wind, der an der Meeresoberfläche weht, haben keinen Einfluss auf ihn.

Die Messdaten werden an Satelliten übermittelt, welche die Position der Drifter ermitteln und die Daten an Bodenstationen weiter leiten. Häufig findet sich die Bezeichnung "Lagrange'sche" Drifter. Die Bezeichnung entstammt der Hydrodynamik, benutzt den Namen eines Mathematikers und steht bei der Beschreibung von Strömungen für Teilchen, die sich mit der Strömung bewegen.

Treibbojen werden im Rahmen von Forschungsprogrammen wie WOCE oder TOGA eingesetzt.

|

Komponenten eines Drifters Alle Drifter messen die Temperatur der Meeresoberfläche, aber die meisten sind auch für die Messung anderer Variablen ausgerüstet. Während sich der Drifter durch die Meeresströmungen bewegt, können Messungen des atmosphärischen Drucks, der Winde, der Wellenhöhe und des Salzgehalts vorgenommen werden. Diese Daten werden von Sensoren im Drifter erfasst und an Satelliten übertragen. Durch die Verfolgung der Position der Drifter im Laufe der Zeit können die Wissenschaftler ein Profil der Meeresströmungen erstellen. Der Treibanker eines Drifters, auch Meeresanker genannt, reicht 20 Meter tief und ist so konzipiert, dass er sich mit den oberflächennahen Meeresströmungen bewegt. Der Treibanker und der Oberflächenschwimmer bewegen sich gemeinsam, verbunden durch eine lange Leine. Ohne Treibanker wird der Drifter von Wind und Wellen getragen, ähnlich wie ein Tischtennisball oder ein Strandball über die Oberfläche eines Schwimmbeckens geschoben wird. Quelle: NOAA |

Weitere Informationen:

- Global Drifter Program (NOAA AOML)

- Drifter Types (Scripps)

- The journey of a Drifting Buoy (BOM, YouTube)

Messung von Temperaturen im oberen Ozean mit Bathythermographen

Zum einmaligen Gebrauch bestimmte Bathythermographen (XBT, Expendable Bathythermograph) werden seit Jahren von Ozeanographen eingesetzt, um Informationen über die ozeanische Temperaturstruktur bis in Tiefen von 1.500 m zu erhalten. Der XBT ist eine ("Wegwerf"-)Sonde, die von einem Schiff ins Wasser gelassen wird und beim Abtauchen die Temperatur misst. Ein zweiadriges, dünnes Kupferkabel überträgt die Daten zum Schiff, wo sie zur späteren Auswertung gespeichert oder an Satelliten zur Weiterleitung übermittelt werden. Die Sonde ist so konstruiert, dass sie mit gleichmässiger Geschwindigkeit fällt, so dass die jeweilige Tiefe der Sonde anhand der Zeit seit ihrer Wasserung ermittelt werden kann. Auf diese Weise kann die gemessene Temperatur mit der zugehörigen Tiefe verknüpft werden.

|

XBT-Sonde im Vorratsbehälter (links) und in Explosionsansicht (rechts) |

Automatische Mehrfach-Startvorrichtung für XBT-Sonden |

XBT-Start mit Einfachwerfer |

|

|

Quellen: NOAA / ARGO / PolarTREC |

|

XBTs werden gewöhnlich im Rahmen eines freiwilligen Beobachtungsprogramms durch Handels-, Kriegs- oder Forschungsschiffe (Ship Of Opportunity Program, SOOP) eingesetzt. Dazu hat die NOAA ein Instrumenten- und Übertragungssystem entwickelt, das die Daten von u.a. XBT-Messungen über Satelliten an Bodenstationen übermittelt.

Daten über die Temperaturen des oberen Ozeans sind insbesondere für die Entwicklung gekoppelter Atmosphäre-Ozean-Modelle wichtig.

Weitere Informationen: XBT Network (NOAA AOLM)

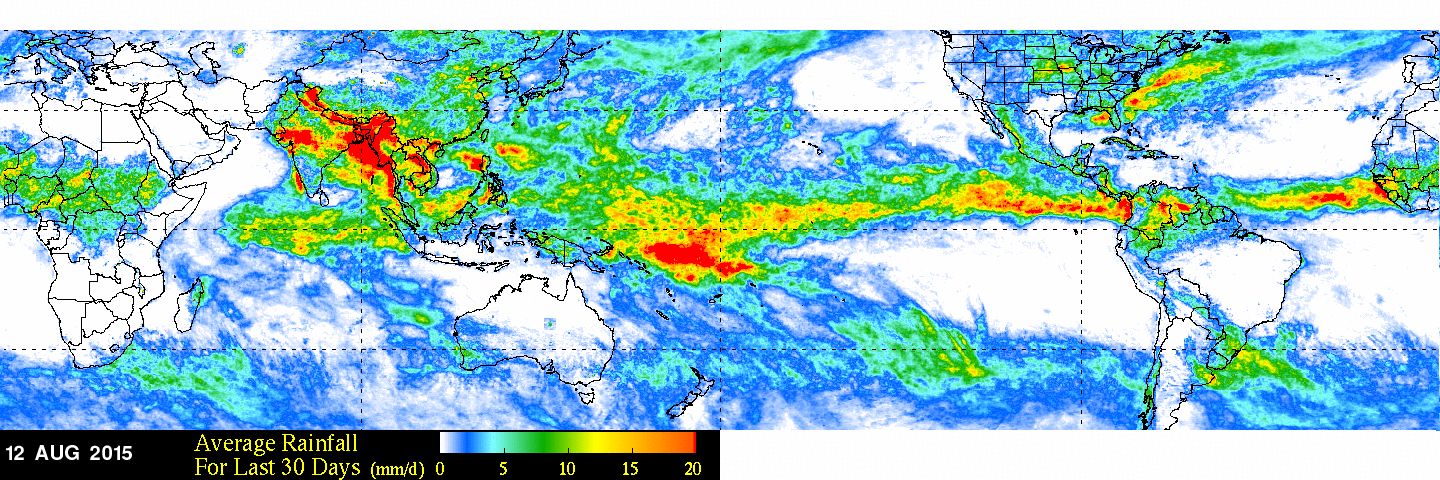

Niederschlagsmessung im Rahmen von TRMM und der Nachfolgemission GPM

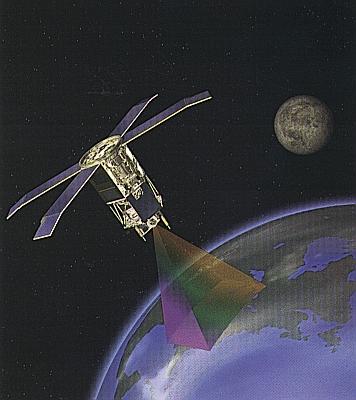

Die japanisch-amerikanische Mission zur Messung des Niederschlags in den gesamten Tropen und Subtropen (Tropical Rainfall Measuring Mission, TRMM), die im November 1997 ihren Betrieb aufnahm und bis 2015 aktiv war, setzte zum ersten Mal im Weltraum aktive (Radar-) und passive Mikrowellendetektoren ein, die Informationen über Niederschlag, Bewölkung und Strahlungsvorgänge in den Tropen und Subtropen lieferten. Sie kombinierte damit auch Daten aus dem sichtbaren, infraroten und dem Mikrowellenbereich. Die Daten unterstützten auch operationelle Anwendungen wie Überschwemmungs- und Dürre-Monitoring und Wettervorhersagen.

|

TRMM über einem tropischen Wirbelsturm

Link: |

TRMM mit seinen fünf Instrumenten und deren Aufnahmemodi |

Die Umlaufbahn des TRMM-Satelliten ist kreisförmig in einer Höhe von 350 km und überstreicht einen Bereich zwischen 35 Grad Nord und 35 Grad Süd. Für einen Umlauf benötigt der Satellit ca. 91 Minuten. Zu den beobachteten Gebieten gehören auch jene, in denen El Niño auftritt. Eine der bemerkenswertesten Auswirkungen von El Niño ist die fast weltweite Änderung der Niederschlagsmuster.

|

Vergleich der globalen Niederschlagsverteilung Januar 1998 / 1999 (Schwerpunkt Tropen) Die Abbildungen zeigen die globale Niederschlagsverteilung für die Monate Januar 1998 (links) und Januar 1999 (rechts) nach den Beobachtungen des Niederschlagsradars von TRMM. El Niño-bedingte Veränderungen der Niederschlagsverteilung im pazifischen Raum sind deutlich erkennbar. Quelle: NASA SVS |

|

Tropischer Niederschlag macht mehr als 2/3 des globalen Niederschlags aus. Er ist der hauptsächliche Verteiler von Wärmeenergie im System der planetarischen Zirkulation, da der Wechsel des Aggregatzustandes von Wasser (flüssig - gasförmig - flüssig) das Speichern von latenter Wärme ermöglicht. Das Verständnis des Niederschlags und seiner Variabilität ist entscheidend für das Verständnis des globalen Klimas und die Vorhersage seiner Veränderung. Unser gegenwärtiges Wissen über Niederschlag ist dünn, insbesondere über dem Ozean.

Satelliten messen den Niederschlag mit Hilfe der sichtbaren, infraroten und der Mikrowellenkanäle. Bei der Verwendung von Informationen aus dem sichtbaren und infraroten Bereich werden die Regenmengen vorhergesagt, indem man Formeln benutzt, die auf dem Wolkentyp, dem Prozentsatz wolkenbedeckter Fläche und einem numerischen Faktor basieren, welcher das Niederschlagspotential eines bestimmten Wolkentyps beschreibt.

Mikrowellensensoren können teilweise durch Wolken mit ihren Wassertröpchen hindurch "sehen". Bei Mikrowellenfrequenzen unter 50 GHz beeinflussen Wolken nur geringfügig das Signal, das vom Satelliten empfangen wird. Regentropfen hingegen haben eigentümliche Absorptions-, Streuungs- und Emisionseigenschaften im Mikrowellenbereich und beeinflussen stark das von den Satelliten empfangene Signal. Dieses Signal ändert sich in Abhängigkeit von der Anzahl und Größe der Regentropfen, die sich im Beobachtungsbereich des Sensors befinden.

Die TRMM ging im April 2015 offiziell zu Ende, nachdem sie 17 Jahre lang wertvollste Daten geliefert hatte, obwohl ihre vorgesehene Lebensdauer nur 3 Jahre betrug. Die nunmehr globale Nachfolgemission, die auf dem Erfolg von TRMM aufbaut, ist GPM Core Observatory, ein Satellit, der im Februar 2014 vom Tanegashima Space Center in Japan gestartet wurde.

|

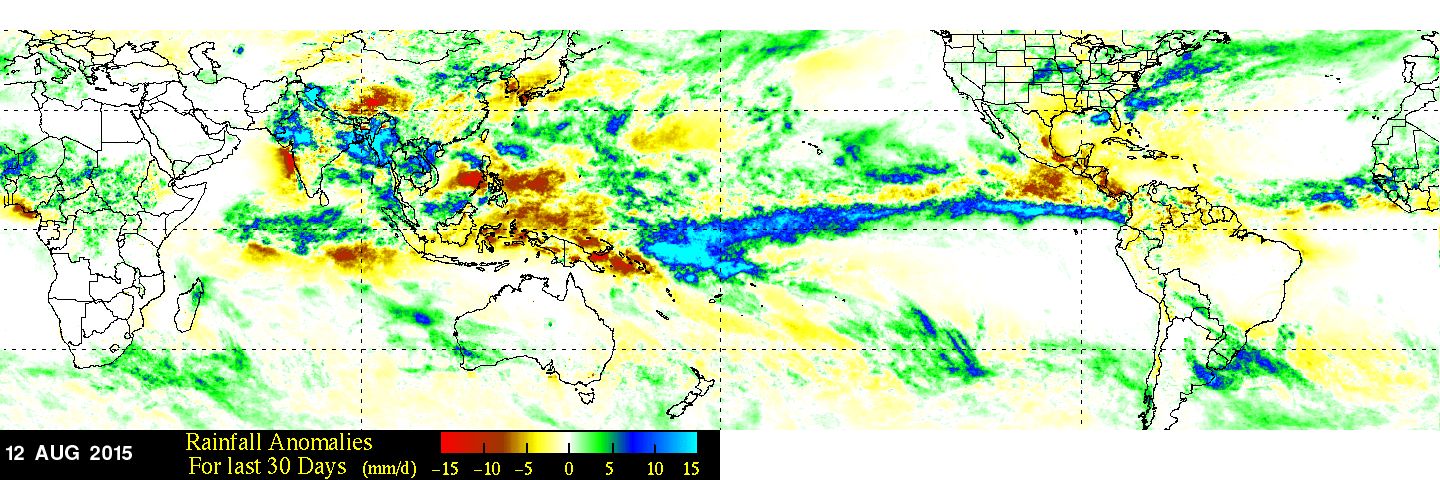

Oben: Durchschnittlicher Niederschlag der vergangenen 30 Tage (mm/d)

Unten: Niederschlagsanomalien der vergangenen 30 Tage (mm/d) Bezugsdatum: 12. August 2015 Der Vorgänger von GPM, die Tropical Rainfall Measuring Mission (TRMM), misst starken bis mäßigen Regen über tropischen und subtropischen Ozeanen. GPM bietet erweiterte Messungen, einschließlich der Abdeckung mittlerer bis hoher Breitengrade, verbesserte Schätzungen von leichtem Regen und Schneefall, erweiterte Schätzungen über Land und Ozean sowie die Koordination von Radar- und Mikrowellenabfragen zur Vereinheitlichung und Verfeinerung der Niederschlagsschätzungen einer Konstellation von Forschungs- und Betriebssatelliten. Das GPM liefert auch häufigere Beobachtungen, alle 2 bis 4 Stunden. Quelle: NASA (R.o.) |

Weitere Informationen:

- TRMM (NASA)

- TRMM (JAXA)

- Global Precipitation Measurement - GPM (NASA / GSFC)

- Near-Realtime IMERG Early Run Half-Hourly Image (NASA / GSFC)

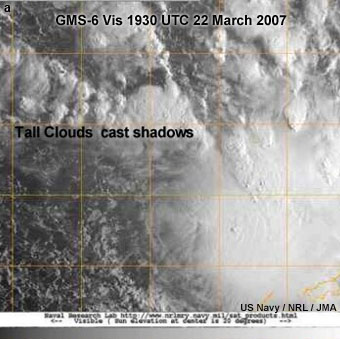

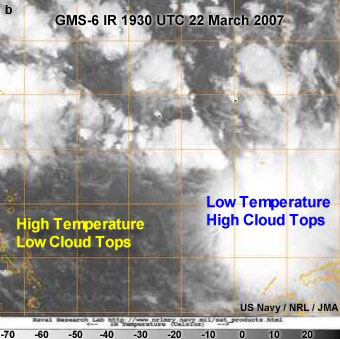

Beobachtung von Wolkensystemen mit geostationären Satelliten

Während eines El Niño-Ereignisses verlagert sich das Gebiet mit ausgeprägten tropischen Wolkensystemen vom Westpazifik zum zentralen und östlichen Pazifik. Die sich auftürmende Cumulonimbusbewölkung folgt dabei dem ostwärts wandernden pazifischen Warmwasserkörper. Die Verlagerung der Wolkenkomplexe kann mit den amerikanischen Geostationary Operational Environmental Satellites (GOES) und den japanischen Geostationary Meteorological Satellites (GMS), bzw. dem Nachfolgesystem MTSAT beobachtet werden. GOES-West, stationiert über dem östlichen Pazifik und GMS, stationiert über dem westlichen Pazifk sind geostationäre Wettersatelliten, die zusammen eine komplette Beobachtung der Wolkentätigkeit über dem Pazifikbecken ermöglichen. Das wichtigste meteorologische Instrument für Wolkenaufnahmen ist das Visible and Infrared Spin Scan Radiometer (VISSR). VISSR arbeitet im sichtbaren und infraroten Bereich des Spektrums und wird eingesetzt um Tages- und Nachtbilder zu erhalten. Im sichtbaren Bereich werden Daten tagsüber alle 30 Minuten aufgenommen, im Infrarotbereich ebenfalls halbstündig, aber über den ganzen Tag hinweg.

|

Geostationärer Satellitenorbit (GOES) Der geostationäre Orbit ermöglicht es Satelliten, ein Phänomen oder ein Objekt mit großer Frequenz zu beobachten, was z.B. das GOES-System höchst nützlich macht für die Beobachtung von Naturgefahren wie Gewitter, Hurrikane, Brände, Vulkanausbrüche und Staubstürme. Quellen: MetEd / UCAR (Zugang über kostenfreie Registrierung) |

Im sichtbaren Kanal misst VISSR die Menge der sichtbaren Strahlung, die zum Satelliten zurück gestrahlt wird. Die mächigsten konvektiven Wolken reflektieren mehr Sonnenlicht und erscheinen am hellsten auf den Satellitenbildern. Im Infrarotkanal misst VISSR sowohl die Strahlungsmenge, die von der Erdoberfläche als auch jene, die von der Wolkenoberseite emittiert wird. Da die Oberseiten hoher Wolken tiefere Temperaturen haben als jene tieferer Wolken, emittieren sie weniger Strahlung. Diese Information kann zur Höhenbestimmung der Wolkenoberseiten verwendet werden. Die Kombination von Bildern aus dem sichtbaren und dem infraroten Bereich ist nützlich, wenn man mit dem Ziel Modelle zu erstellen, Wolkentypen klassifiziert. Die Computermodellierung von El Niño und anderen tropischen Wettersystemen erfordert u.a. die Kenntnis des Strahlungshaushaltes, da unterschiedliche Wolkentypen eine verschieden große Menge an Sonnenstrahlung auf die Erdoberfläche durchläßt und umgekehrt unterschiedliche Wärmemengen in obere Atmosphärenschichten gelangen lässt.

Meteorologen nutzen Wolkenmuster, um Wetterphänomene wie die ITCZ, tropische Wirbelstürme, Meeresbrisen und Tornados zu finden. Wolken bedecken fast zwei Drittel der Erdoberfläche und tragen dazu bei, die Strahlungsbilanz des Systems Erde-Atmosphäre zu regulieren. Die Satelliten-Fernerkundung ist die wichtigste Methode zur Beobachtung und Dokumentation der globalen Strahlungseigenschaften von Wolken. Eine Vielzahl neuer Satellitensensoren hilft den Wissenschaftlern außerdem, mehr über die Struktur, die Formen und die mikrophysikalischen Eigenschaften von Wolken zu verstehen.

|

Wolken markieren Wettererscheinungen über dem Südwestpazifik. Links: Satellitenbild im sichtbaren Bereich des Spektrums Rechts: Infrarot-Satellitenbild Die 3-D-Natur von Wolken ist auf sichtbaren Satellitenbildern ersichtlich, in denen hervorstehende Wolken Schatten erzeugen, insbesondere bei niedrigen Sonneneinfallwinkeln (Abb. links). Die Höhe der Wolkendecke kann anhand von Satellitenmessungen der von der Wolkendecke emittierten IR-Strahlungsdichte geschätzt werden, die eine Funktion der absoluten Temperatur ist. Im Allgemeinen sind in den Tropen wärmere Wolkendecken niedriger und kältere Wolkendecken höher (Abb. rechts). In der letzten Jahren haben neue Satellitensensoren mit gleichzeitigen, mehrwinkligen Beobachtungen 3-D-Ansichten von Wolken geliefert. Quelle: MetEd / UCAR (Zugang über kostenfreie Registrierung) |

Die hohe Bildwiederholfrequenz erlaubt es den Wissenschaftlern, Wolkenbewegungen und -entwicklungen sowie die Bildung von tropischen Stürmen während eines El Niño-Ereignisses genau zu beobachten. Die Verfügbarkeit von raschen Bildfolgen ist entscheidend für die Beobachtung der rasch entstehenden tropischen Stürme. Tropische Stürme können sich zu Hurrikanen entwickeln und sich auf bewohnte Inseln und dicht bevölkerte Küstenstriche zu bewegen. Das Bildmaterial erlaubt auch die Abschätzung der zu erwartenden Niederschlagsmengen. Dieser Satellitentyp eignet sich demnach vor allem für kurzfristige Warnungen.

Zwei weitere geostationäre Satellitensysteme, INSAT und METEOSAT ermöglichen es Meteorologen die Telekonnektionen zu untersuchen, die z.B. mit El Niño-bedingter Wolkenaktivität über dem Indischen und dem Atlantischen Ozean verbunden sind.

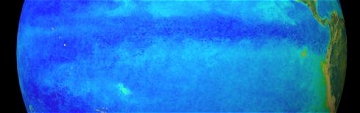

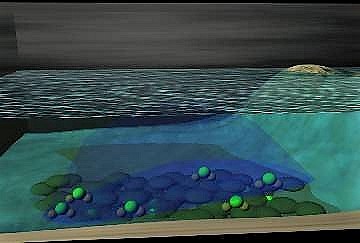

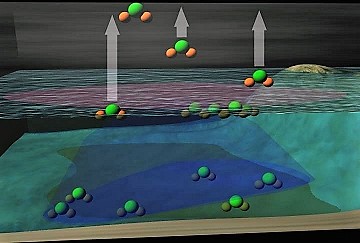

Erhebung bio-optischer Daten mit Hilfe von SeaWiFS

Mikroskopische Pflanzen im Wasser, das sogenannte Phytoplankton, enthalten Chlorophyll und andere Farbpigmente. Diese tragen zur Farbe des Ozeans bei, die abhängig von der Konzentration des Phytoplanktons variiert.

Quelle: NASA

|

|

Links: Der SeaStar-Satellit im Orbit (M.b.) Verschiedene Farben des Ozeans zeigen das Vorhandensein verschiedener Arten und Mengen von marinem Phytoplankton an, das eine Rolle beim Austausch von wichtigen Elementen und Gasen zwischen der Atmosphäre und den Ozeanen spielt. Der Satellit überwachte auch kleinste Veränderungen in der Farbe des Ozeans überwachen, um Veränderungen in der Menge des marinen Phytoplanktons zu beurteilen. Er lieferte Daten, um besser zu verstehen, wie diese Veränderungen die globale Umwelt und die Rolle der Ozeane im globalen Kohlenstoffkreislauf und anderen biogeochemischen Kreisläufen beeinflussen. Die Mission war eine Fortsetzung des Coastal Zone Color Scanners (CZCS) und erfasste die Ozeane alle zwei Tage vollständig. Rechts: Das SeaWIFS-Instrument Nur ein Instrument wurde mitgeführt: der Sea-viewing Wide Field-of-view Sensor (SeaWiFS). Bestehend aus einem optischen Scanning-Teleskop und einem Elektronikmodul, bildete SeaWiFS die Ozeane der Erde in 8 Frequenzbändern ab. Das Scanning-Teleskop rotierte mit sechs Umdrehungen pro Sekunde in der Querrichtung, um eine Scan-Abdeckung mit einer räumlichen Auflösung von 1,13 km zu erreichen. |

SeaWiFS (Sea-viewing Wide Field-of-view Sensor) ist ein inzwischen inaktives Instrument, das in der Lage war, diese geringfügigen Farbunterschiede zu registrieren. Es bestand aus einem optischen Scanner im sichtbaren und nahen Infrarot-Bereich sowie einem Elektronikmodul. SeaWiFS war das Nachfolgeexperiment des Coastal Zone Color Scanners an Bord von Nimbus 7. An Bord des GeoEye-Satelliten Orb-View-2 (auch bekannt als SeaStar) lieferte es aktuelle Daten zur Farbe der Ozeane und damit zur Menge und zur Art des Phytoplanktons in einem bestimmten Gebiet. Dies wiederum erlaubte Rückschlüsse auf den Zustand des Ozeans.

SeaStar wurde 1997 mit einer Pegasus-Rakete aus einem Flugzeug in etwa 10 km Höhe in den Erd-Orbit befördert, wo er in 278 km Höhe abgesetzt wurde. Mit einem eigenen Antrieb flog SeaStar dann zu seiner endgültigen Position in 705 km Höhe, wo er in sonnensynchronem Orbit die Erde umkreist. Das Projekt SeaWiFS gehört zum NASA-Programm Earth Observing System. Der Satellit ging Mitte 2011 verloren.

Die Aufgabe des Instruments bestand darin, große Mengen an Daten über die biooptischen Eigenschaften der Ozeane zu sammeln. Kaum sichtbare Unterschiede in der Farbe der Ozeane weisen auf verschiedene Arten und Konzentrationen von Phytoplankton hin.

Mit SeaWiFS konnte man feststellen, dass die Chlorophyll-Konzentration in einem großen Bereich des Pazifiks durch El Niño 1997/98 dramatisch reduziert wurde. Es war also bedeutend weniger Phytoplankton vorhanden. Im Sommer 1998 mit La Niña-Bedingungen gab es dann jedoch ein großes Wachstum mikroskopischer Algen in der Region.

Da Phytoplankton an erster Stelle in der Nahrungskette steht, hatte dies auch einen enormen Einfluss auf alle anderen Lebewesen im Wasser. Besser als je zuvor konnte der enorme Einfluss von El Niño auf die Tier- und Pflanzenwelt gezeigt werden. Man erkannte aber gleichzeitig auch, wie schnell sich der Ozean danach wieder erholt hat. Der Grund für die Reduzierung des Phytoplanktons war der ausbleibende Auftrieb nährstoffreichen Wassers, wodurch dem Phytoplankton die Nahrungsgrundlage entzogen wurde.

Quelle: NASA/Goddard Space Flight Center - SeaWiFS

Quelle: NASA/Goddard Space Flight Center - SeaWiFS

Quelle: NASA/Goddard Space Flight Center - SeaWiFS

Quelle: NASA/Goddard Space Flight Center - SeaWiFS

Mit dem Rückgang der Primärproduktion in den küstennahen Auftriebsgebieten und den äquatorialen Divergenzgebieten während El Niño-Ereignissen sollte man mit einer Zunahme der CO2-Abgabe des Ozeans an die Atmosphäre rechnen. Schließlich führt die verminderte Phytoplanktonproduktion zu erhöhten CO2-Konzentrationen in den oberen Wasserschichten und zu einer reduzierten Aufnahme von atmosphärischem CO2 durch den Ozean. In Wirklichkeit nimmt jedoch die CO2-Konzentration in der oberen Durchmischungsschicht ab. Zum Verständnis muss man wissen, dass die äquatorialen Divergenzgebiete durch das Upwelling von CO2-reichen Tiefenwässern bedeutende Bereiche für die Abgabe von CO2 an die Atmosphäre sind. Während El Niño-freien Jahren ist der aufwärtige Transport besonders stark, und damit auch die Abgabe von CO2 an die Atmosphäre. Dieser Effekt überkompensiert die Bindung von ursprünglich atmosphärischem Kohlendioxid durch die wegen des Nährstoffnachschubs verstärkte Primärproduktion.

Man schätzt, dass beim El Niño 1997/98 - verglichen mit dem Vorjahr - eine CO2-Menge, die etwa der Hälfte der jährlichen CO2-Abgabe durch die Verbrennung fossiler Brennstoffe in den USA entspricht, weniger in die Atmosphäre abgegeben wurde.

Durch das Verständnis des Ausmaßes der riesigen Planktonblüte konnten die Wissenschaftler berechnen, wie die Veränderungen der biologischen Aktivität massive Veränderungen des Kohlendioxids verursachten. Die Wissenschaftler stellten fest, dass El Niño die Menge des in die Atmosphäre abgegebenen Kohlendioxids um 700 Millionen Tonnen verringerte. Normalerweise setzen die tiefen Gewässer der Ozeane große Mengen an Kohlendioxid frei. Während El Niño wurde das kohlenstoffdioxidreiche Wasser unter der Oberfläche gehalten.

Quelle: NASA/Goddard Space Flight Center - SeaWiFS

Quelle: NASA/Goddard Space Flight Center - SeaWiFS

Quelle: NASA/Goddard Space Flight Center - SeaWiFS

Quelle: NASA/Goddard Space Flight Center - SeaWiFS

Daten zur Farbe des Ozeans liefern weiterhin beipielsweise die Instrumente MODIS auf den Satelliten Terra und Aqua, OLI auf Landsat-8 oder VIIRS auf Suomi-NPP.

Im Kapitel 'Aktueller Zustand des Pazifiks' befinden sich Links zu Internet-Seiten, auf denen man Karten mit der aktuellen Chlorophyll-Konzentration in den Weltmeeren findet.

Neuere Beobachtungsmethoden

Wissenschaftler der GFZ-Sektion Erdsystem-Modellierung entwickeln einen neuen Weg zur ENSO-Beobachtung: Die Betrachtung der ozeanischen Magnetfelder, die aus der Wechselwirkung zwischen Erdmagnetfeld und Gezeitenströmung entstehen. Sie könnte die Vorhersage von ENSO-Ereignissen verbessern und grundlegende Prozesse erklären helfen.

Die durch ENSO verursachten Veränderungen in Temperatur und Salzgehalt des Meerwassers haben einen unmittelbaren Einfluss auf die elektrische Leitfähigkeit des Wassers. Die Leitfähigkeit wiederum beeinflusst die Stärke des ozeanischen Magnetfelds, das durch Wechselwirkungen zwischen Erdmagnetfeld und Gezeiten entsteht. Die Wissenschaftler zeigen in einer numerischen Modellstudie, dass Messungen dieser Magnetfeldstärken das Potenzial haben, als früher Indikator für das Auftreten eines El Niño oder La Niña-Ereignisses zu dienen. Ihre Ergebnisse veröffentlichten sie 2018 in der Fachzeitschrift Ocean Science.

Mithilfe eines Ozean-Atmosphäre-Modells simulierten die Wissenschaftler ozeanische Strömungen, Temperaturen und Salzgehalte über eine Zeitspanne von 50 Jahren. Daraus berechneten sie die ozeanischen Magnetfeldstärken.Sie konnten zeigen, dass in ihrer Simulation einem ENSO-Ereignis immer eine veränderte Amplitude des Gezeitenmagnetfeldes vorausging. Und zwar statistisch etwa vier Monate bevor die ebenfalls typischen Temperaturveränderungen an der Wasseroberfläche auftreten. Grund dafür ist, dass sich vor einem ENSO-Ereignis das vertikale Temperaturprofil im äquatorialen Pazifik verändert, also die Temperaturverteilung in der Tiefe. Das hat eine Änderung in der ozeanischen Leitfähigkeit zur Folge die sich auf die ozeanischen Magnetfeldstärken auswirkt.

Bisher gelingen Magnetfeldmessungen in ausreichender Genauigkeit für eine ENSO-Vorhersage nur im Labor. Mit verbesserter Technik könnte jedoch in Zukunft eine auf den Veränderungen des Gezeitenmagnetfelds basierende Vorhersage für ENSO-Ereignisse möglich werden und die negativen Folgen für beispielsweise die Fischereiindustrie abmildern. (GFZ)

ENSO-Vorhersagen

Überblick

Das primäre Ziel einer ENSO-Vorhersage ist es, die relative Wahrscheinlichkeit von regionalen Klimaanomalien besser zu prognostizieren (Goddard & DeWitt 2005). Die Fähigkeit, El Niño- und La Niña-Ereignisse verlässlich mit ihren Amplituden, Zeitverläufen und Strukturen vorherzusagen, ist äußerst wichtig, da diese Ereignisse in der Regel mit konstanten Klimaschwankungen in den Tropen verbunden sind und sogar die Atmosphäre auf der ganzen Welt beeinflussen können.

In den letzten Jahrzehnten wurden viele Fortschritte gemacht, damit El Niño und La Niña und ihre globalen Folgen besser verstanden werden können. Vorhersagen können von großem Wert sein u. a. für Behörden, Katastrophenmanager, Wasserwirtschaftler, Landwirte, Fischer und Einzelpersonen in potentiell von extremen Witterungsereignissen betroffenen Regionen.

Tatsächlich ist das Interesse an ENSO-Vorhersagen nicht neu. Der erste Versuch, einen El Niño vorherzusagen, wurde 1974, vor gut 45 Jahren, von Bill Quinn von der Oregon State University und Klaus Wyrtki von der University of Hawaii unternommen. Sie wurden durch den El Niño von 1972-73 motiviert, der einen Zusammenbruch der peruanischen Sardellenfischerei, der damals größten der Welt auslöste, mit Folgen, die sich auf die gesamte Weltwirtschaft auswirkten (Glantz, 2001). Ihre Hoffnung war es, ein zuverlässiges Prognoseverfahren zu entwickeln, mit dem zukünftige El Niño-Ereignisse weit genug im Voraus antizipiert werden können, um Präventivmaßnahmen zu ergreifen. (McPhaden et al. 2015)

Als Reaktion auf den El Niño 1982-83 expandierte die Überwachung und Modellierung von ENSO rasant (s. Klimamodelle). Eine der ersten Errungenschaften war die erfolgreiche Prognose des El Niño von 1986-87, mit Vorlaufzeiten von 3 bis 9 Monaten durch Mark Cane und Steve Zebiak am Lamont-Doherty Geological Observatory, Columbia University. (MetEd/UCAR)

Die seitherige, aber nicht durchgängige Verbesserung der Vorhersagbarkeit von ENSO-Ereignissen in den letzten Jahrzehnten kann mehreren Faktoren zugeschrieben werden. Vor allem die erheblich optimierten Systeme der Datenverarbeitung, Datenanalyse und -assimilation, schnellere Computer mit höherer Speicherkapazität und ein gesteigertes Verständnis der physikalischen Vorgänge des tropischen Ozeans und der tropischen Atmosphäre, die der Entwicklung des ENSO-Phänomens zu Grunde liegen, sind dafür verantwortlich.

Auch hat theoretische Arbeit von Wissenschaftlern zum Verständnis destabilisierter äquatorialer Wellen (Philander et al., 1984) und einer Theorie für den Übergang zwischen warmen und kalten Zuständen geführt (z.B. der sogenannte delayed oscillator oder der recharge oscillator, Suarez und Schopf, 1988; Battisti und Hirst, 1989; Jin, 1997; Kirtman, 1997). Darüber hinaus beschreibt dieses theoretische Verständnis deutlich die wissenschaftliche Grundlage für ENSO-Vorhersagen, dass nämlich die Wärmestruktur unter der Ozeanoberfläche oder auch Verlagerungen der Thermokline Vorläufer für ENSO-Ereignisse sind und somit für Vorhersagen verwendet werden können. (National Research Council 2010)

Mittlerweile gilt das ENSO-Phänomen als die am besten vorhersagbare kurzzeitige Schwankung des Klimasystems der Erde. Dennoch sind die Grenzen der Vorhersagbarkeit weiterhin Gegenstand intensiver Diskussion.

Datenerhebung für die Vorhersagen

Aufgrund der sozialen Auswirkungen auf die Ankündigung eines sich entwickelnden El Niño müssen die Messungen verifiziert und genau sein. Ein ENSO-Indikator ist der Southern Oscillation Index (SOI), der aus der Druckdifferenz zwischen Tahiti und Darwin berechnet wird. Der SOI ist in El Niño-Jahren negativ und in La Niña-Jahren positiv. Da die SOI-Messungen lokale Schwankungen und Wetterstörungen widerspiegeln können, berechnen Wissenschaftler in der Regel die Messwerte über einen Zeitraum von 5 Monaten, um festzustellen, ob die Druckschwankungen auf ein Großereignis hinweisen.

Darüber hinaus unterhält die NOAA im Bereich des äquatorialen Pazifiks ein System von Überwachungsbojen, das Tropical Atmosphere Ocean (TAO) Array. Die Bojen erfassen und übertragen Temperaturen von der Wasseroberfläche und dem oberen Wasserkörper, Daten der atmosphärischen Bedingungen, Wasserströmungen und Winddaten in Echtzeit an Wissenschaftler und Forscher auf der ganzen Welt.

Auch die automatisierten Treibbojen des internationalen Argo-Programms mit ihren Messungen zu Temperatur, Leitfähigkeit und Druck in der Wassersäule.sind hier zu nennen.

Weitere Verfahren sind bereits im ersten Teil dieses Kapitels vorgestellt.

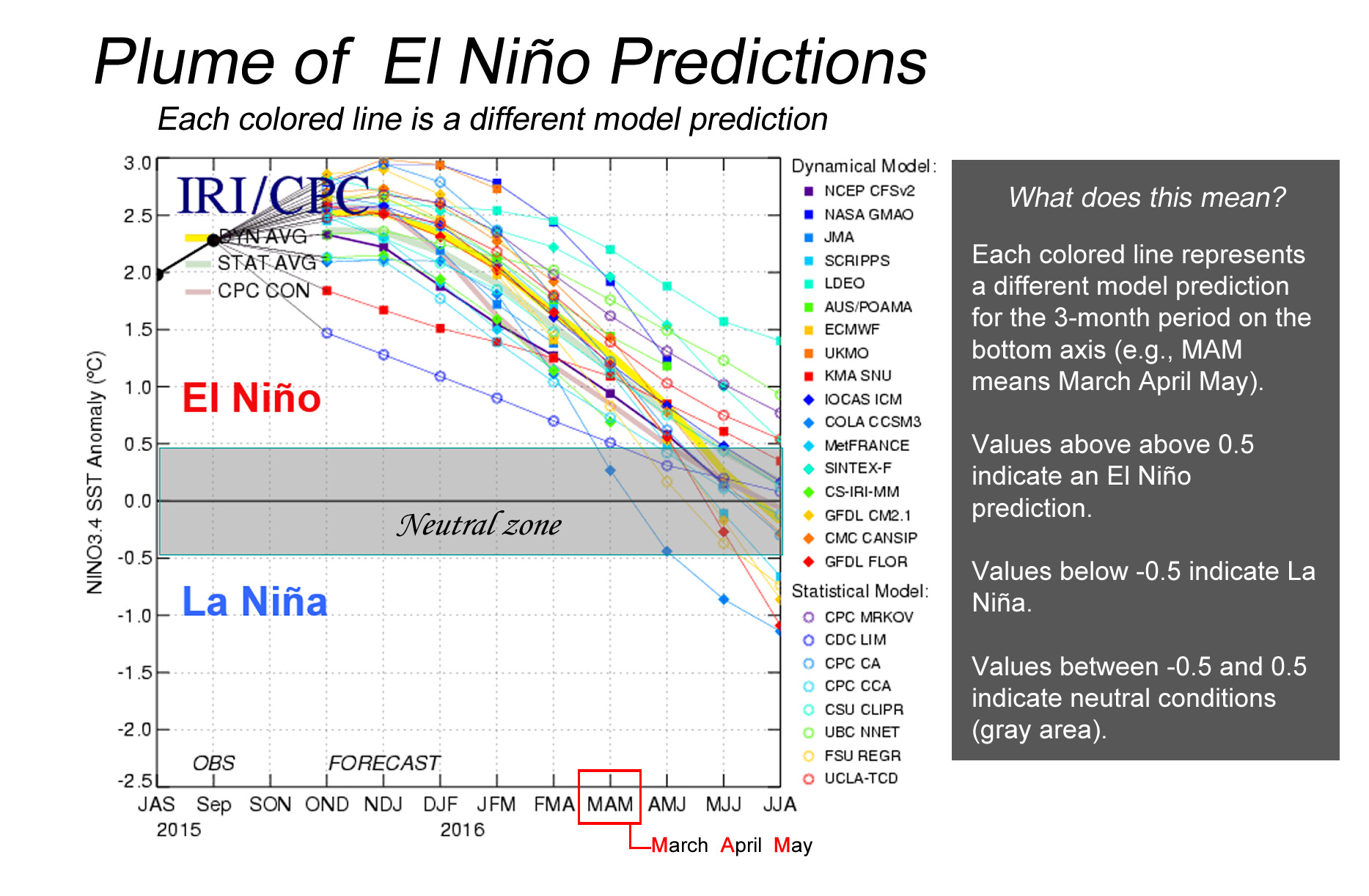

Vorgehensweise bei den Vorhersagen